教程地址:主页 - LearnOpenGL CN

常用库¶

GLFW¶

- 用于窗口管理、处理输入、创建 opengl 上下文等

- GLFW 封装了底层窗口系统的实现,提供了跨平台的接口

- GLFW 提供了键盘、鼠标和游戏手柄的输入支持

- GLFW 支持 Windows、macOS 和 Linux,帮助你实现一次编写、跨平台运行的代码

基本使用¶

-

参数配置:以键值对的形式进行配置

- 如配置版本号位

3.3glfwWindowHint(GLFW_CONTEXT_VERSION_MAJOR, 3); glfwWindowHint(GLFW_CONTEXT_VERSION_MINOR, 3);

- 如配置版本号位

-

创建一个简单的窗口对象并设置为上下文

GLFWwindow* window = glfwCreateWindow(800, 600,"LearnOpenGL", NULL, NULL); glfwMakeContextCurrent(window); -

注册回调,当窗口大小调整时自动调整视口的大小

void framebuffer_size_callback(GLFWwindow* window, int width, int height) { glViewport(0, 0, width, height); } glfwSetFramebufferSizeCallback(window,framebuffer_size_callback); -

最简答的事件循环

while(!glfwWindowShouldClose(window)) { glfwSwapBuffers(window); glfwPollEvents(); } - glfwWindowShouldClose函数在我们每次循环的开始前检查一次GLFW是否被要求退出

- glfwPollEvents函数检查有没有触发什么事件(比如键盘输入、鼠标移动等)、更新窗口状态,并调用对应的回调函数。

- glfwSwapBuffers函数会交换颜色缓冲,它在这一迭代中被用来绘制,并且将会作为输出显示在屏幕上。

- 双缓冲:下一帧完全渲染完之后再进行交换,避免由于渲染过程造成闪烁

-

在循环中可以进行输入检查控制

void processInput(GLFWwindow* window) { if (glfwGetKey(window, GLFW_KEY_ESCAPE) == GLFW_PRESS) glfwSetWindowShouldClose(window, true); } -

完整的代码

#include <glad\glad.h> #include <GLFW\glfw3.h> #include <iostream> void framebuffer_size_callback(GLFWwindow* window, int width, int height) { glViewport(0, 0, width, height); } void processInput(GLFWwindow* window) { if (glfwGetKey(window, GLFW_KEY_ESCAPE) == GLFW_PRESS) glfwSetWindowShouldClose(window, true); } int main() { //参数设置 glfwInit(); glfwWindowHint(GLFW_CONTEXT_VERSION_MAJOR, 3); glfwWindowHint(GLFW_CONTEXT_VERSION_MINOR, 3); glfwWindowHint(GLFW_OPENGL_PROFILE, GLFW_OPENGL_CORE_PROFILE); //创建上下文 GLFWwindow* window = glfwCreateWindow(800, 600, "LearnOpenGL", NULL, NULL); if (window == NULL) { std::cout << "Failed to create GLFW window" << std::endl; glfwTerminate(); return -1; } glfwMakeContextCurrent(window); //板顶函数 if (!gladLoadGLLoader((GLADloadproc)glfwGetProcAddress)) { std::cout << "Failed to initialize GLAD" << std::endl; return -1; } //设置视口大小 glfwSetFramebufferSizeCallback(window, framebuffer_size_callback); while (!glfwWindowShouldClose(window)) { // 输入 processInput(window); // 渲染指令 glClearColor(0.2f, 0.3f, 0.3f, 1.0f);//设置清除用的颜色 glClear(GL_COLOR_BUFFER_BIT); // 检查并调用事件,交换缓冲 glfwSwapBuffers(window); glfwPollEvents(); } //释放资源 glfwTerminate(); return 0; } - glClear 用于清除缓冲,可选参数如:GL_COLOR_BUFFER_BIT,GL_DEPTH_BUFFER_BIT和GL_STENCIL_BUFFER_BIT 用于清除不同的数据

GLAD¶

- 是一个 OpenGL 扩展加载器,一个基于 OpenGL 函数指针的加载库,用于加载不同 OpenGL 版本的函数

- OpenGL 本身并不包含所有的函数定义和实现,因此你需要一个加载器来动态加载这些函数地址

-

由于不同操作系统和驱动支持不同版本的 opengl,因此不能直接调用这些函数,而是通过函数加载器来获取这些函数的地址

-

加载函数

if (!gladLoadGLLoader((GLADloadproc)glfwGetProcAddress)) { std::cout << "Failed to initialize GLAD" << std::endl; return -1; } - 函数指针的地址只有在创建了 OpenGL 上下文后才能正确获取。GLFW 负责初始化和创建这个 OpenGL 上下文,这是 GLAD 开始加载 OpenGL 函数的前提条件。(提供了获取函数地址的方法)

- GLAD 就可以通过

glfwGetProcAddress动态加载所有 OpenGL 函数,而不需要开发者关心平台差异。 - 基本流程就是:使用 GLFW 创建 OpenGL 上下文->使用 GLAD 加载 OpenGL 函数->程序可以调用 OpenGL 函数

stb_image¶

- 可以使用

stb_image.h下载来进行文件图像加载,加载为char*字节量

unsigned int loadTexture(char const* path)

{

unsigned int textureID;

glGenTextures(1, &textureID);

int width, height, nrComponents;

unsigned char* data = stbi_load(path, &width, &height, &nrComponents, 0);

if (data)

{

GLenum format;

if (nrComponents == 1)

format = GL_RED;

else if (nrComponents == 3)

format = GL_RGB;

else if (nrComponents == 4)

format = GL_RGBA;

glBindTexture(GL_TEXTURE_2D, textureID);

glTexImage2D(GL_TEXTURE_2D, 0, format, width, height, 0, format, GL_UNSIGNED_BYTE, data);

glGenerateMipmap(GL_TEXTURE_2D);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_WRAP_S, GL_REPEAT);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_WRAP_T, GL_REPEAT);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_MIN_FILTER, GL_LINEAR_MIPMAP_LINEAR);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_MAG_FILTER, GL_LINEAR);

stbi_image_free(data);

}

else

{

std::cout << "Texture failed to load at path: " << path << std::endl;

stbi_image_free(data);

}

return textureID;

}

unsigned int diffuseMap = loadTexture("container2.png");

GLM¶

- 用于opengl的数学库

- GLM库从0.9.9版本起,默认会将矩阵类型初始化为一个零矩阵(所有元素均为0),而不是单位矩阵

- 需要初始化为单位矩阵

glm::mat4 mat = glm::mat4(1.0f) glm是一个头文件库,它不生成动态链接库(.dll)或静态库(.lib),可以直接在项目中包含glm的头文件来使用它。- 常用头文件内容

#include <glm/glm.hpp>

#include <glm/gtc/matrix_transform.hpp>

#include <glm/gtc/type_ptr.hpp>

- 可以用glm快速创建各种变换矩阵

glm::vec4 vec(1.0f, 0.0f, 0.0f, 1.0f);

// 译注:下面就是矩阵初始化的一个例子,如果使用的是0.9.9及以上版本

// 下面这行代码就需要改为:

// glm::mat4 trans = glm::mat4(1.0f)

// 之后将不再进行提示

glm::mat4 trans;

trans = glm::translate(trans, glm::vec3(1.0f, 1.0f, 0.0f));

vec = trans * vec;

//glm::radians(90.0f)将角度转化为弧度

//glm::vec3(0.0, 0.0, 1.0)指定旋转方向

trans = glm::rotate(trans, glm::radians(90.0f), glm::vec3(0.0, 0.0, 1.0));

trans = glm::scale(trans, glm::vec3(0.5, 0.5, 0.5));

-

用同一个矩阵

trans可以进行不同的变化,glm会自动将变化乘到trans上,最终用trans乘以目标矩阵就可以实现所有变化(注意变化倒序执行,上面就是先缩放再旋转) -

将变化矩阵传递给着色器

uniform mat4 transform;就可以传递一个四维矩阵

#version 330 core

layout (location = 0) in vec3 aPos;

layout (location = 1) in vec2 aTexCoord;

out vec2 TexCoord;

uniform mat4 transform;

void main()

{

gl_Position = transform * vec4(aPos, 1.0f);

TexCoord = vec2(aTexCoord.x, 1.0 - aTexCoord.y);

}

unsigned int transformLoc = glGetUniformLocation(ourShader.ID, "transform");

glUniformMatrix4fv(transformLoc, 1, GL_FALSE, glm::value_ptr(trans));

- 1表示要传递的矩阵数目

- GL_FALSE表示是否需要转置矩阵

- value_ptr将glm矩阵转化为opengl可以接受的

Assimp¶

- 用于模型的加载

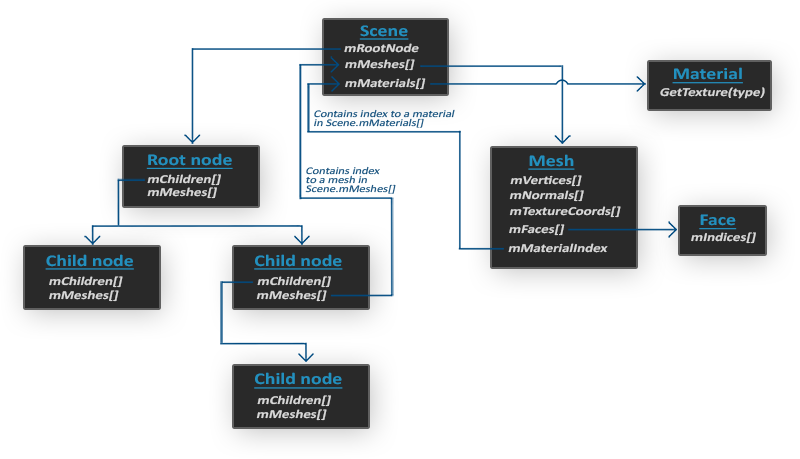

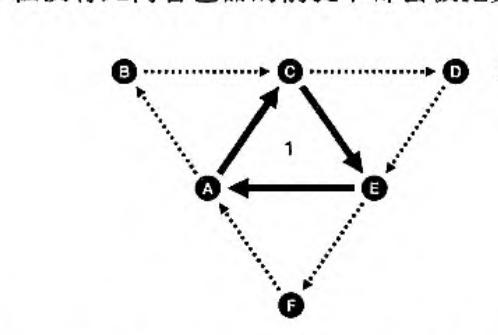

- 当使用Assimp导入一个模型的时候,它通常会将整个模型加载进一个场景(Scene)对象,它会包含导入的模型/场景中的所有数据。Assimp会将场景载入为一系列的节点(Node),每个节点包含了场景对象中所储存数据的索引,每个节点都可以有任意数量的子节点。

- rootnode存储子节点引用(模型通常不是一个整体,而是由许多子部分组成)

- mesh存储网格信息,如顶点位置、法向量、纹理坐标、面等

-

material

-

Scene中的mMeshes数组是一个全局变量,存储整个场景中所有的网格数据

- 而node中的mMeshes等数组存储的是当前节点所包含的网格数据的索引(实际的数据还是在scene中)

网格加载¶

- 网格数据类

//网格中一点至少包含位置坐标、法向量、uv坐标

struct Vertex {

glm::vec3 Position;

glm::vec3 Normal;

glm::vec2 TexCoords;

};

//储存纹理的id以及它的类型

struct Texture {

unsigned int id;

string type;

};

class Mesh {

public:

/* 网格数据 */

vector<Vertex> vertices;//顶点数据

vector<unsigned int> indices;//索引数据

vector<Texture> textures;//贴图数据

/* 函数 */

Mesh(vector<Vertex> vertices, vector<unsigned int> indices, vector<Texture> textures);

void Draw(Shader shader);

private:

/* 渲染数据 */

unsigned int VAO, VBO, EBO;

/* 函数 */

void setupMesh();

};

Mesh(vector<Vertex> vertices, vector<unsigned int> indices, vector<Texture> textures)

{

this->vertices = vertices;

this->indices = indices;

this->textures = textures;

setupMesh();

}

//建立、绑定数据

void setupMesh()

{

glGenVertexArrays(1, &VAO);

glGenBuffers(1, &VBO);

glGenBuffers(1, &EBO);

glBindVertexArray(VAO);

glBindBuffer(GL_ARRAY_BUFFER, VBO);

glBufferData(GL_ARRAY_BUFFER, vertices.size() * sizeof(Vertex), &vertices[0], GL_STATIC_DRAW);

glBindBuffer(GL_ELEMENT_ARRAY_BUFFER, EBO);

glBufferData(GL_ELEMENT_ARRAY_BUFFER, indices.size() * sizeof(unsigned int),

&indices[0], GL_STATIC_DRAW);

// 顶点位置

glEnableVertexAttribArray(0);

glVertexAttribPointer(0, 3, GL_FLOAT, GL_FALSE, sizeof(Vertex), (void*)0);

// 顶点法线

glEnableVertexAttribArray(1);

glVertexAttribPointer(1, 3, GL_FLOAT, GL_FALSE, sizeof(Vertex), (void*)offsetof(Vertex, Normal));

// 顶点纹理坐标

glEnableVertexAttribArray(2);

glVertexAttribPointer(2, 2, GL_FLOAT, GL_FALSE, sizeof(Vertex), (void*)offsetof(Vertex, TexCoords));

glBindVertexArray(0);

}

void Draw(Shader shader)

{

unsigned int diffuseNr = 1;

unsigned int specularNr = 1;

for(unsigned int i = 0; i < textures.size(); i++)

{

glActiveTexture(GL_TEXTURE0 + i); // 在绑定之前激活相应的纹理单元

// 获取纹理序号(diffuse_textureN 中的 N)

string number;

string name = textures[i].type;

if(name == "texture_diffuse")

number = std::to_string(diffuseNr++);

else if(name == "texture_specular")

number = std::to_string(specularNr++);

shader.setInt(("material." + name + number).c_str(), i);

glBindTexture(GL_TEXTURE_2D, textures[i].id);

}

glActiveTexture(GL_TEXTURE0);

// 绘制网格

glBindVertexArray(VAO);

glDrawElements(GL_TRIANGLES, indices.size(), GL_UNSIGNED_INT, 0);

glBindVertexArray(0);

}

- 着色器中使用贴图的命名规范:

uniform sampler2D texture_diffuse1;

uniform sampler2D texture_diffuse2;

uniform sampler2D texture_diffuse3;

uniform sampler2D texture_specular1;

uniform sampler2D texture_specular2;

- 完整版,附带切线、骨骼参数的shader类型

#ifndef MESH_H

#define MESH_H

#include <glad/glad.h> // holds all OpenGL type declarations

#include <glm/glm.hpp>

#include <glm/gtc/matrix_transform.hpp>

#include <learnopengl/shader.h>

#include <string>

#include <vector>

using namespace std;

#define MAX_BONE_INFLUENCE 4

struct Vertex {

// position

glm::vec3 Position;

// normal

glm::vec3 Normal;

// texCoords

glm::vec2 TexCoords;

// tangent

glm::vec3 Tangent;

// bitangent

glm::vec3 Bitangent;

//bone indexes which will influence this vertex

int m_BoneIDs[MAX_BONE_INFLUENCE];

//weights from each bone

float m_Weights[MAX_BONE_INFLUENCE];

};

struct Texture {

unsigned int id;

string type;

string path;

};

class Mesh {

public:

// mesh Data

vector<Vertex> vertices;

vector<unsigned int> indices;

vector<Texture> textures;

unsigned int VAO;

// constructor

Mesh(vector<Vertex> vertices, vector<unsigned int> indices, vector<Texture> textures)

{

this->vertices = vertices;

this->indices = indices;

this->textures = textures;

// now that we have all the required data, set the vertex buffers and its attribute pointers.

setupMesh();

}

// render the mesh

void Draw(Shader &shader)

{

// bind appropriate textures

unsigned int diffuseNr = 1;

unsigned int specularNr = 1;

unsigned int normalNr = 1;

unsigned int heightNr = 1;

for(unsigned int i = 0; i < textures.size(); i++)

{

glActiveTexture(GL_TEXTURE0 + i); // active proper texture unit before binding

// retrieve texture number (the N in diffuse_textureN)

string number;

string name = textures[i].type;

if(name == "texture_diffuse")

number = std::to_string(diffuseNr++);

else if(name == "texture_specular")

number = std::to_string(specularNr++); // transfer unsigned int to string

else if(name == "texture_normal")

number = std::to_string(normalNr++); // transfer unsigned int to string

else if(name == "texture_height")

number = std::to_string(heightNr++); // transfer unsigned int to string

// now set the sampler to the correct texture unit

glUniform1i(glGetUniformLocation(shader.ID, (name + number).c_str()), i);

// and finally bind the texture

glBindTexture(GL_TEXTURE_2D, textures[i].id);

}

// draw mesh

glBindVertexArray(VAO);

glDrawElements(GL_TRIANGLES, static_cast<unsigned int>(indices.size()), GL_UNSIGNED_INT, 0);

glBindVertexArray(0);

// always good practice to set everything back to defaults once configured.

glActiveTexture(GL_TEXTURE0);

}

private:

// render data

unsigned int VBO, EBO;

// initializes all the buffer objects/arrays

void setupMesh()

{

// create buffers/arrays

glGenVertexArrays(1, &VAO);

glGenBuffers(1, &VBO);

glGenBuffers(1, &EBO);

glBindVertexArray(VAO);

// load data into vertex buffers

glBindBuffer(GL_ARRAY_BUFFER, VBO);

// A great thing about structs is that their memory layout is sequential for all its items.

// The effect is that we can simply pass a pointer to the struct and it translates perfectly to a glm::vec3/2 array which

// again translates to 3/2 floats which translates to a byte array.

glBufferData(GL_ARRAY_BUFFER, vertices.size() * sizeof(Vertex), &vertices[0], GL_STATIC_DRAW);

glBindBuffer(GL_ELEMENT_ARRAY_BUFFER, EBO);

glBufferData(GL_ELEMENT_ARRAY_BUFFER, indices.size() * sizeof(unsigned int), &indices[0], GL_STATIC_DRAW);

// set the vertex attribute pointers

// vertex Positions

glEnableVertexAttribArray(0);

glVertexAttribPointer(0, 3, GL_FLOAT, GL_FALSE, sizeof(Vertex), (void*)0);

// vertex normals

glEnableVertexAttribArray(1);

glVertexAttribPointer(1, 3, GL_FLOAT, GL_FALSE, sizeof(Vertex), (void*)offsetof(Vertex, Normal));

// vertex texture coords

glEnableVertexAttribArray(2);

glVertexAttribPointer(2, 2, GL_FLOAT, GL_FALSE, sizeof(Vertex), (void*)offsetof(Vertex, TexCoords));

// vertex tangent

glEnableVertexAttribArray(3);

glVertexAttribPointer(3, 3, GL_FLOAT, GL_FALSE, sizeof(Vertex), (void*)offsetof(Vertex, Tangent));

// vertex bitangent

glEnableVertexAttribArray(4);

glVertexAttribPointer(4, 3, GL_FLOAT, GL_FALSE, sizeof(Vertex), (void*)offsetof(Vertex, Bitangent));

// ids

glEnableVertexAttribArray(5);

glVertexAttribIPointer(5, 4, GL_INT, sizeof(Vertex), (void*)offsetof(Vertex, m_BoneIDs));

// weights

glEnableVertexAttribArray(6);

glVertexAttribPointer(6, 4, GL_FLOAT, GL_FALSE, sizeof(Vertex), (void*)offsetof(Vertex, m_Weights));

glBindVertexArray(0);

}

};

#endif

模型加载¶

- 加载模型并转化为多个mesh对象

class Model

{

public:

/* 函数 */

Model(char *path)

{

loadModel(path);

}

void Draw(Shader shader);

private:

/* 模型数据 */

vector<Mesh> meshes;

string directory;

/* 函数 */

void loadModel(string path);

void processNode(aiNode *node, const aiScene *scene);

Mesh processMesh(aiMesh *mesh, const aiScene *scene);

vector<Texture> loadMaterialTextures(aiMaterial *mat, aiTextureType type,

string typeName);

};

void Model::Draw(Shader &shader)

{

for(unsigned int i = 0; i < meshes.size(); i++)

meshes[i].Draw(shader);

}

- 使用assimp来加载模型:

aiProcess_Triangulate表示将模型的所有图元变换为三角形aiProcess_FlipUVs表示在处理时翻转y轴纹理坐标aiProcess_GenNormals如果模型不包含法向量的话,就为每个顶点创建法线aiProcess_SplitLargeMeshes将比较大的网格分割成更小的子网格aiProcess_OptimizeMeshes将多个小网格拼接为一个大的网格,减少绘制调用从而进行优化

void Model::loadModel(string path)

{

Assimp::Importer import;

const aiScene *scene = import.ReadFile(path, aiProcess_Triangulate | aiProcess_FlipUVs);

//检查是否加载出错

if(!scene || scene->mFlags & AI_SCENE_FLAGS_INCOMPLETE || !scene->mRootNode)

{

cout << "ERROR::ASSIMP::" << import.GetErrorString() << endl;

return;

}

directory = path.substr(0, path.find_last_of('/'));

//遍历assimp节点树

processNode(scene->mRootNode, scene);

}

void Model::processNode(aiNode *node, const aiScene *scene)

{

// 处理节点所有的网格(如果有的话)

for(unsigned int i = 0; i < node->mNumMeshes; i++)

{

//根据索引从全局数据中取出mesh数据

aiMesh *mesh = scene->mMeshes[node->mMeshes[i]];

meshes.push_back(processMesh(mesh, scene));

}

// 接下来对它的子节点重复这一过程

for(unsigned int i = 0; i < node->mNumChildren; i++)

{

processNode(node->mChildren[i], scene);

}

}

- 实际上可以忽略节点,直接对全局数据中的mesh遍历渲染,但是保留节点层次结构,可以便于进行更多操作

Mesh Model::processMesh(aiMesh *mesh, const aiScene *scene)

{

vector<Vertex> vertices;

vector<unsigned int> indices;

vector<Texture> textures;

for(unsigned int i = 0; i < mesh->mNumVertices; i++)

{

Vertex vertex;

glm::vec3 vector;

//处理坐标

vector.x = mesh->mVertices[i].x;

vector.y = mesh->mVertices[i].y;

vector.z = mesh->mVertices[i].z;

vertex.Position = vector;

vertices.push_back(vertex);

//处理法线

vector.x = mesh->mNormals[i].x;

vector.y = mesh->mNormals[i].y;

vector.z = mesh->mNormals[i].z;

vertex.Normal = vector;

//处理纹理坐标

if(mesh->mTextureCoords[0]) // 网格是否有纹理坐标?

{

glm::vec2 vec;

vec.x = mesh->mTextureCoords[0][i].x;

vec.y = mesh->mTextureCoords[0][i].y;

vertex.TexCoords = vec;

}

else

vertex.TexCoords = glm::vec2(0.0f, 0.0f);

}

// 处理索引

for(unsigned int i = 0; i < mesh->mNumFaces; i++)

{

aiFace face = mesh->mFaces[i];

for(unsigned int j = 0; j < face.mNumIndices; j++)

indices.push_back(face.mIndices[j]);

}

// 处理材质

if(mesh->mMaterialIndex >= 0)

{

aiMaterial *material = scene->mMaterials[mesh->mMaterialIndex];

vector<Texture> diffuseMaps = loadMaterialTextures(material,

aiTextureType_DIFFUSE, "texture_diffuse");

textures.insert(textures.end(), diffuseMaps.begin(), diffuseMaps.end());

vector<Texture> specularMaps = loadMaterialTextures(material,

aiTextureType_SPECULAR, "texture_specular");

textures.insert(textures.end(), specularMaps.begin(), specularMaps.end());

}

return Mesh(vertices, indices, textures);

}

- 首先根据index获取aiMaterial材质对象,然后从中加载漫反射、镜面反射等贴图,

vector<Texture> Model::loadMaterialTextures(aiMaterial *mat, aiTextureType type, string typeName)

{

vector<Texture> textures;

for(unsigned int i = 0; i < mat->GetTextureCount(type); i++)

{

aiString str;

mat->GetTexture(type, i, &str);

Texture texture;

texture.id = TextureFromFile(str.C_Str(), directory);

texture.type = typeName;

texture.path = str;

textures.push_back(texture);

}

return textures;

}

-

进一步优化:全局存储贴图,在加载之前先判断是否已经加载过了

-

完整代码

#ifndef MODEL_H

#define MODEL_H

#include <glad/glad.h>

#include <glm/glm.hpp>

#include <glm/gtc/matrix_transform.hpp>

#include <stb_image.h>

#include <assimp/Importer.hpp>

#include <assimp/scene.h>

#include <assimp/postprocess.h>

#include <learnopengl/mesh.h>

#include <learnopengl/shader.h>

#include <string>

#include <fstream>

#include <sstream>

#include <iostream>

#include <map>

#include <vector>

using namespace std;

unsigned int TextureFromFile(const char *path, const string &directory, bool gamma = false);

class Model

{

public:

// model data

vector<Texture> textures_loaded; // stores all the textures loaded so far, optimization to make sure textures aren't loaded more than once.

vector<Mesh> meshes;

string directory;

bool gammaCorrection;

// constructor, expects a filepath to a 3D model.

Model(string const &path, bool gamma = false) : gammaCorrection(gamma)

{

loadModel(path);

}

// draws the model, and thus all its meshes

void Draw(Shader &shader)

{

for(unsigned int i = 0; i < meshes.size(); i++)

meshes[i].Draw(shader);

}

private:

// loads a model with supported ASSIMP extensions from file and stores the resulting meshes in the meshes vector.

void loadModel(string const &path)

{

// read file via ASSIMP

Assimp::Importer importer;

const aiScene* scene = importer.ReadFile(path, aiProcess_Triangulate | aiProcess_GenSmoothNormals | aiProcess_FlipUVs | aiProcess_CalcTangentSpace);

// check for errors

if(!scene || scene->mFlags & AI_SCENE_FLAGS_INCOMPLETE || !scene->mRootNode) // if is Not Zero

{

cout << "ERROR::ASSIMP:: " << importer.GetErrorString() << endl;

return;

}

// retrieve the directory path of the filepath

directory = path.substr(0, path.find_last_of('/'));

// process ASSIMP's root node recursively

processNode(scene->mRootNode, scene);

}

// processes a node in a recursive fashion. Processes each individual mesh located at the node and repeats this process on its children nodes (if any).

void processNode(aiNode *node, const aiScene *scene)

{

// process each mesh located at the current node

for(unsigned int i = 0; i < node->mNumMeshes; i++)

{

// the node object only contains indices to index the actual objects in the scene.

// the scene contains all the data, node is just to keep stuff organized (like relations between nodes).

aiMesh* mesh = scene->mMeshes[node->mMeshes[i]];

meshes.push_back(processMesh(mesh, scene));

}

// after we've processed all of the meshes (if any) we then recursively process each of the children nodes

for(unsigned int i = 0; i < node->mNumChildren; i++)

{

processNode(node->mChildren[i], scene);

}

}

Mesh processMesh(aiMesh *mesh, const aiScene *scene)

{

// data to fill

vector<Vertex> vertices;

vector<unsigned int> indices;

vector<Texture> textures;

// walk through each of the mesh's vertices

for(unsigned int i = 0; i < mesh->mNumVertices; i++)

{

Vertex vertex;

glm::vec3 vector; // we declare a placeholder vector since assimp uses its own vector class that doesn't directly convert to glm's vec3 class so we transfer the data to this placeholder glm::vec3 first.

// positions

vector.x = mesh->mVertices[i].x;

vector.y = mesh->mVertices[i].y;

vector.z = mesh->mVertices[i].z;

vertex.Position = vector;

// normals

if (mesh->HasNormals())

{

vector.x = mesh->mNormals[i].x;

vector.y = mesh->mNormals[i].y;

vector.z = mesh->mNormals[i].z;

vertex.Normal = vector;

}

// texture coordinates

if(mesh->mTextureCoords[0]) // does the mesh contain texture coordinates?

{

glm::vec2 vec;

// a vertex can contain up to 8 different texture coordinates. We thus make the assumption that we won't

// use models where a vertex can have multiple texture coordinates so we always take the first set (0).

vec.x = mesh->mTextureCoords[0][i].x;

vec.y = mesh->mTextureCoords[0][i].y;

vertex.TexCoords = vec;

// tangent

vector.x = mesh->mTangents[i].x;

vector.y = mesh->mTangents[i].y;

vector.z = mesh->mTangents[i].z;

vertex.Tangent = vector;

// bitangent

vector.x = mesh->mBitangents[i].x;

vector.y = mesh->mBitangents[i].y;

vector.z = mesh->mBitangents[i].z;

vertex.Bitangent = vector;

}

else

vertex.TexCoords = glm::vec2(0.0f, 0.0f);

vertices.push_back(vertex);

}

// now wak through each of the mesh's faces (a face is a mesh its triangle) and retrieve the corresponding vertex indices.

for(unsigned int i = 0; i < mesh->mNumFaces; i++)

{

aiFace face = mesh->mFaces[i];

// retrieve all indices of the face and store them in the indices vector

for(unsigned int j = 0; j < face.mNumIndices; j++)

indices.push_back(face.mIndices[j]);

}

// process materials

aiMaterial* material = scene->mMaterials[mesh->mMaterialIndex];

// we assume a convention for sampler names in the shaders. Each diffuse texture should be named

// as 'texture_diffuseN' where N is a sequential number ranging from 1 to MAX_SAMPLER_NUMBER.

// Same applies to other texture as the following list summarizes:

// diffuse: texture_diffuseN

// specular: texture_specularN

// normal: texture_normalN

// 1. diffuse maps

vector<Texture> diffuseMaps = loadMaterialTextures(material, aiTextureType_DIFFUSE, "texture_diffuse");

textures.insert(textures.end(), diffuseMaps.begin(), diffuseMaps.end());

// 2. specular maps

vector<Texture> specularMaps = loadMaterialTextures(material, aiTextureType_SPECULAR, "texture_specular");

textures.insert(textures.end(), specularMaps.begin(), specularMaps.end());

// 3. normal maps

std::vector<Texture> normalMaps = loadMaterialTextures(material, aiTextureType_HEIGHT, "texture_normal");

textures.insert(textures.end(), normalMaps.begin(), normalMaps.end());

// 4. height maps

std::vector<Texture> heightMaps = loadMaterialTextures(material, aiTextureType_AMBIENT, "texture_height");

textures.insert(textures.end(), heightMaps.begin(), heightMaps.end());

// return a mesh object created from the extracted mesh data

return Mesh(vertices, indices, textures);

}

// checks all material textures of a given type and loads the textures if they're not loaded yet.

// the required info is returned as a Texture struct.

vector<Texture> loadMaterialTextures(aiMaterial *mat, aiTextureType type, string typeName)

{

vector<Texture> textures;

for(unsigned int i = 0; i < mat->GetTextureCount(type); i++)

{

aiString str;

mat->GetTexture(type, i, &str);

// check if texture was loaded before and if so, continue to next iteration: skip loading a new texture

bool skip = false;

for(unsigned int j = 0; j < textures_loaded.size(); j++)

{

if(std::strcmp(textures_loaded[j].path.data(), str.C_Str()) == 0)

{

textures.push_back(textures_loaded[j]);

skip = true; // a texture with the same filepath has already been loaded, continue to next one. (optimization)

break;

}

}

if(!skip)

{ // if texture hasn't been loaded already, load it

Texture texture;

texture.id = TextureFromFile(str.C_Str(), this->directory);

texture.type = typeName;

texture.path = str.C_Str();

textures.push_back(texture);

textures_loaded.push_back(texture); // store it as texture loaded for entire model, to ensure we won't unnecessary load duplicate textures.

}

}

return textures;

}

};

unsigned int TextureFromFile(const char *path, const string &directory, bool gamma)

{

string filename = string(path);

filename = directory + '/' + filename;

unsigned int textureID;

glGenTextures(1, &textureID);

int width, height, nrComponents;

unsigned char *data = stbi_load(filename.c_str(), &width, &height, &nrComponents, 0);

if (data)

{

GLenum format;

if (nrComponents == 1)

format = GL_RED;

else if (nrComponents == 3)

format = GL_RGB;

else if (nrComponents == 4)

format = GL_RGBA;

glBindTexture(GL_TEXTURE_2D, textureID);

glTexImage2D(GL_TEXTURE_2D, 0, format, width, height, 0, format, GL_UNSIGNED_BYTE, data);

glGenerateMipmap(GL_TEXTURE_2D);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_WRAP_S, GL_REPEAT);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_WRAP_T, GL_REPEAT);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_MIN_FILTER, GL_LINEAR_MIPMAP_LINEAR);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_MAG_FILTER, GL_LINEAR);

stbi_image_free(data);

}

else

{

std::cout << "Texture failed to load at path: " << path << std::endl;

stbi_image_free(data);

}

return textureID;

}

#endif

opengl¶

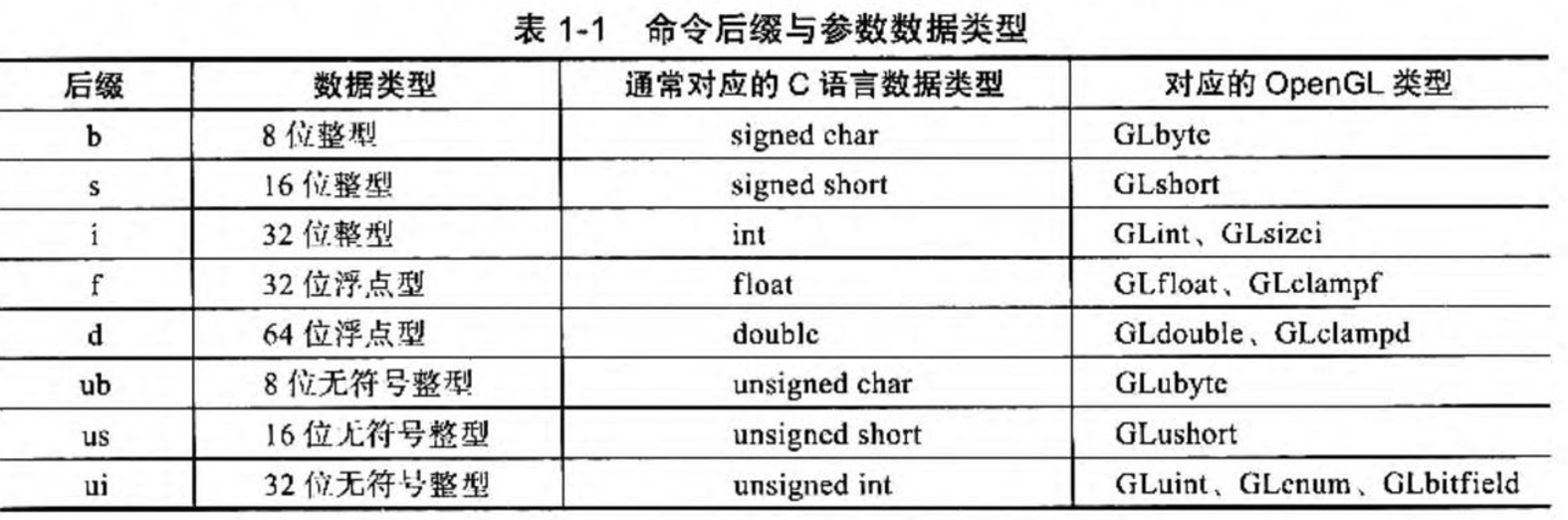

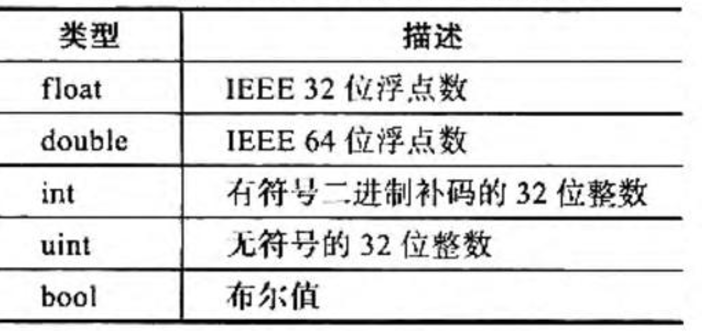

常用的数据类型¶

- 最好使用 opengl 提供的数据类型,这样就能避免在不同版本 opengl 之间一直代码出现不匹配的问题

- 最好使用 opengl 提供的数据类型,这样就能避免在不同版本 opengl 之间一直代码出现不匹配的问题

工作流程¶

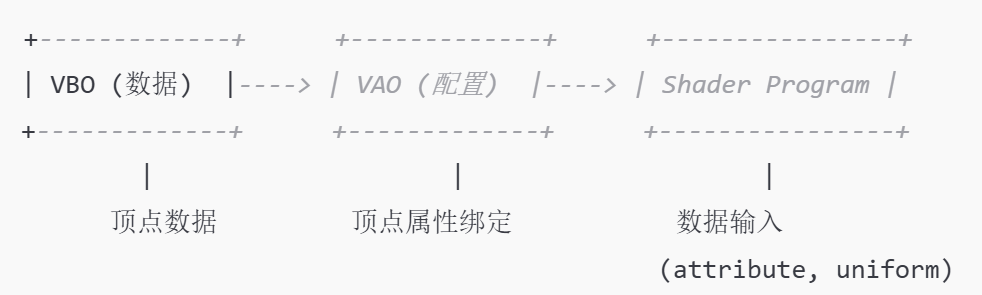

-

几个重要概念

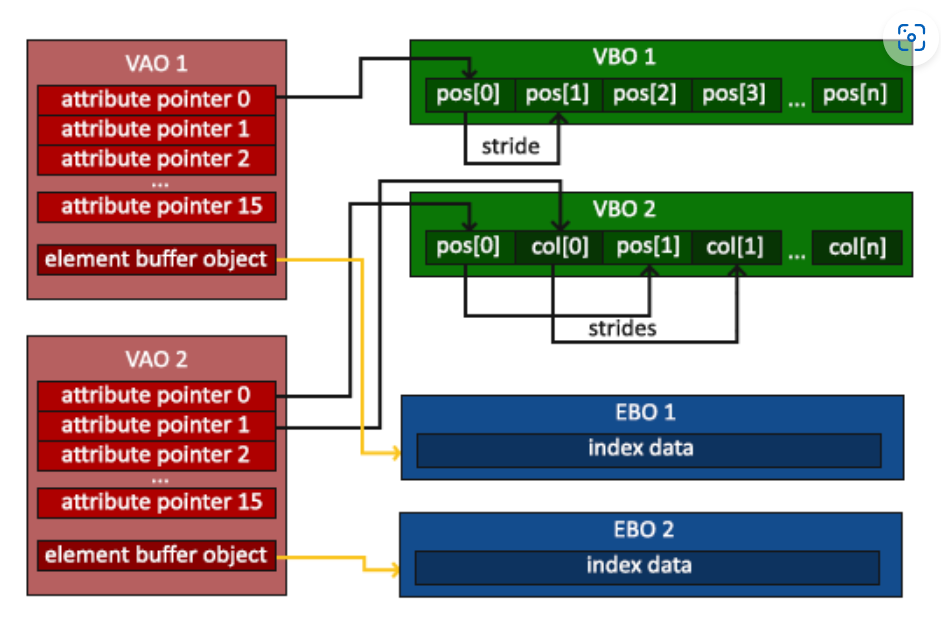

- 顶点数组对象:Vertex Array Object,VAO

- 顶点缓冲对象:Vertex Buffer Object,VBO

-

元素缓冲对象:Element Buffer Object,EBO 或 索引缓冲对象 Index Buffer Object,IBO

-

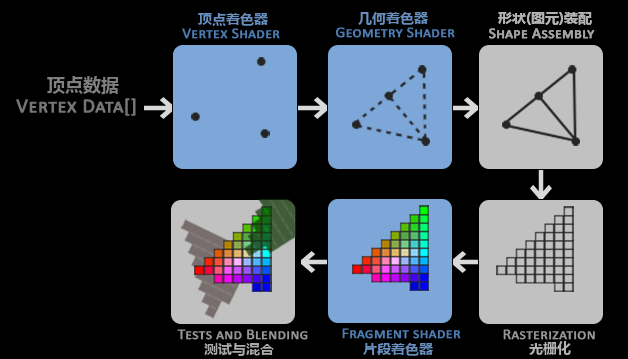

渲染管线接受一组 3 D 坐标,最终转化为屏幕上的 2 D 画面

- 渲染管线包含一系列着色器,流水线处理数据,opengl 中的着色器使用 GLSL 语言

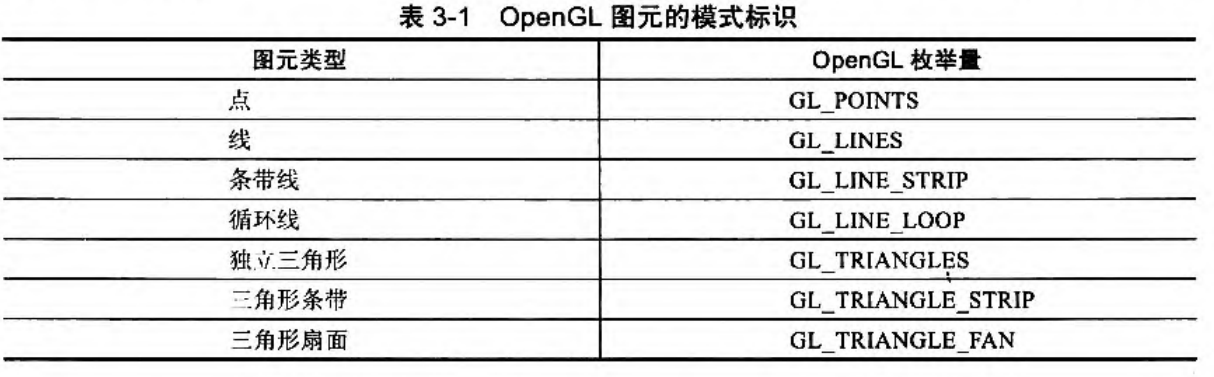

- 图元用于指示 opengl 如何处理输入,如把一系列点绘制成三角形?线?等。即传递绘制指令,如

GL_POINTS、GL_TRIANGLES、GL_LINE_STRIP

基本流程 - 顶点着色器接受单独的顶点作为输入,将 3 D 坐标进行转化(比如转换到 opengl 的可视区域),并对顶点的属性进行一些基本处理 - 几何着色器接受顶点着色器的输出,通过输入的顶点形成图元 - 图元装配阶段将预处理的顶点装配成图元的形状 - 片段着色器就散像素的颜色(结合光照等信息) - 测试与混合阶段进行深度测试,以及不透明度的混合

- opengl 中至少要配置顶点着色器和判断着色器

- opengl 只处理-1~1 立方范围内的信息

- 使用 GLSL 编写着色器,编译之后就可以在程序中使用

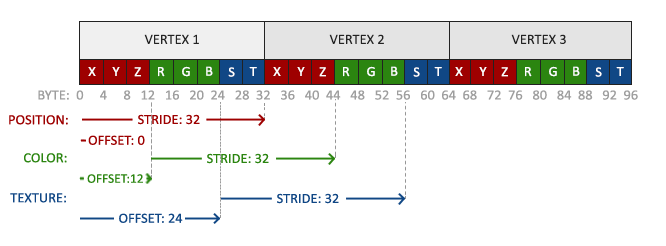

链接顶点属性¶

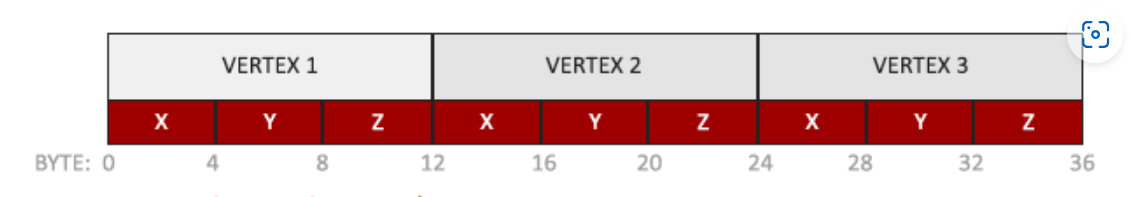

- 上面的三个点以 float 来存储

- 指出如何来解析顶点数据

glVertexAttribPointer(0, 3, GL_FLOAT, GL_FALSE, 3 * sizeof(float), (void*)0); glEnableVertexAttribArray(0); 0表示顶点属性所在的位置(对应编译器中的位置location=0)3表示参数类型的大小(由几个值组成),即 Vec 3GL_FLOAT制定参数的类型GL_FALSE表示是否要进行标准化(0~1)映射3 * sizeof(float)表示连续的属性之间的存储间隔,为 0 时由 opengl 自动决定(连续紧密排列)(void*)0表示数据在缓冲中的起始位置的偏移量-

顶点属性是从之前绑定了

GL_ARRAY_BUFFER的 VBO 顶点缓冲对象来获取的 -

基本工作流程如下

// 0. 复制顶点数组到缓冲中供OpenGL使用

glBindBuffer(GL_ARRAY_BUFFER, VBO);

glBufferData(GL_ARRAY_BUFFER, sizeof(vertices), vertices, GL_STATIC_DRAW);

// 1. 设置顶点属性指针

glVertexAttribPointer(0, 3, GL_FLOAT, GL_FALSE, 3 * sizeof(float), (void*)0);

glEnableVertexAttribArray(0);

// 2. 当我们渲染一个物体时要使用着色器程序

glUseProgram(shaderProgram);

// 3. 绘制物体

someOpenGLFunctionThatDrawsOurTriangle();

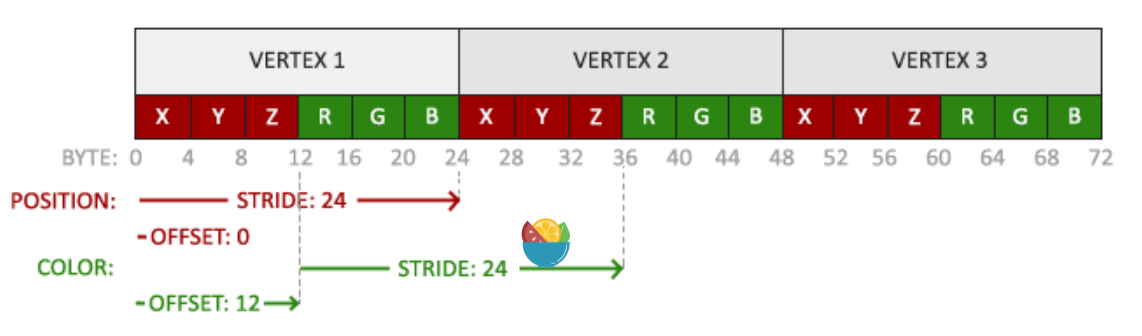

- 当然也可以使用更多的属性,比如位置+颜色

// 位置属性

glVertexAttribPointer(0, 3, GL_FLOAT, GL_FALSE, 6 * sizeof(float), (void*)0);

glEnableVertexAttribArray(0);

// 颜色属性

glVertexAttribPointer(1, 3, GL_FLOAT, GL_FALSE, 6 * sizeof(float), (void*)(3* sizeof(float)));

glEnableVertexAttribArray(1);

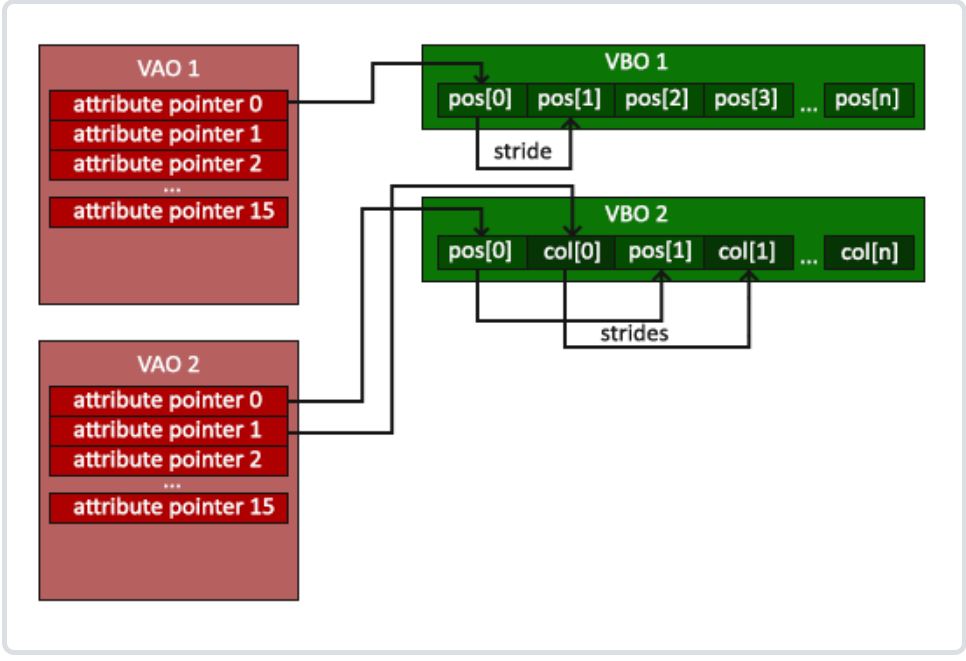

顶点数组对象 VAO¶

- 每次都重新进行绑定设置很麻烦,使用顶点数组对象 VAO可以像顶点缓冲对象那样被绑定,任何随后的顶点属性调用都会储存在这个 VAO 中。

- VAO 是一个容器,用于保存多个 VBO 的状态以及如何解释这些 VBO 中的数据。它记录了如何将 VBO 中的数据绑定到顶点属性上。

- VAO 可以看作是一个“顶点属性的配置快照”。一旦配置好,VAO 会记录下所有与顶点属性相关的状态(例如顶点数据的格式、位置、是否启用等)。

- VAO 本身不直接存储顶点数据,而是保存了 VBO 和顶点属性之间的关联。当绑定 VAO 时,OpenGL 会自动按照配置好的顶点属性状态读取数据。

- VAO 允许我们在绘制不同物体时只需绑定不同的 VAO 就能快速切换顶点属性的配置,方便管理多个物体的不同顶点属性。

- opengl 可以通过 VAO 获取要使用的数据和读取方式

- 即VBO 提供实际的顶点数据,而 VAO 则定义了如何使用这些数据。

- 只需要使用 glBindVertexArray 绑定 VAO

- 绑定之后,所有与顶点属性的设置操作(例如,绑定 VBO、设置顶点属性指针等)都将与这个 VAO 关联。

- 之后通过绑定不同的 VAO,快速切换不同的顶点数据和状态,而无需重新配置顶点属性指针。

//创建VAO

unsigned int VAO;

glGenVertexArrays(1, &VAO);//创建之后还需要进行绑定才能初始化(可以创建指定多个对象,并存储在数组中)

//glCreateVertexArrays直接创建并初始化 VAO,无需绑定,可以直接通过id进行操作

/*

for (int i = 0; i < 3; ++i) {

// 配置VAO,而无需绑定

glVertexArrayAttribBinding(vaos[i], 0, 0); // 配置属性绑定

glVertexArrayAttribFormat(vaos[i], 0, 3, GL_FLOAT, GL_FALSE, 0);

glEnableVertexArrayAttrib(vaos[i], 0);

}

*/

//绑定VAO

glBindVertexArray(VAO);

//解除绑定

glBindVertexArray(0);

元素缓冲对象 EBO¶

-

EBO 是一个缓冲区,就像一个顶点缓冲区对象一样,它存储 OpenGL 用来决定要绘制哪些顶点的索引(决定点的绘制顺序避免性能浪费,比如两个三角拼接成一个矩形)

-

使用索引来用更少的点进行绘制

float vertices[] = {

0.5f, 0.5f, 0.0f, // 右上角

0.5f, -0.5f, 0.0f, // 右下角

-0.5f, -0.5f, 0.0f, // 左下角

-0.5f, 0.5f, 0.0f // 左上角

};

unsigned int indices[] = {

// 注意索引从0开始!

// 此例的索引(0,1,2,3)就是顶点数组vertices的下标,

// 这样可以由下标代表顶点组合成矩形

0, 1, 3, // 第一个三角形

1, 2, 3 // 第二个三角形

};

//创建EBO

unsigned int EBO;

glGenBuffers(1, &EBO);

//把索引复制到缓冲里

glBindBuffer(GL_ELEMENT_ARRAY_BUFFER, EBO);

glBufferData(GL_ELEMENT_ARRAY_BUFFER, sizeof(indices), indices, GL_STATIC_DRAW);

//使用索引进行绘制

glDrawElements(GL_TRIANGLES, 6, GL_UNSIGNED_INT, 0);

- 当目标是 GL_ELEMENT_ARRAY_BUFFER 的时候,VAO 会储存 glBindBuffer 的函数调用,这样使用时就只需要绑定 VAO 而不再需要绑定 EBO

// ..:: 初始化代码 :: ..

// 1. 绑定顶点数组对象

glBindVertexArray(VAO);

// 2. 把我们的顶点数组复制到一个顶点缓冲中,供OpenGL使用

glBindBuffer(GL_ARRAY_BUFFER, VBO);

glBufferData(GL_ARRAY_BUFFER, sizeof(vertices), vertices, GL_STATIC_DRAW);

// 3. 复制我们的索引数组到一个索引缓冲中,供OpenGL使用

glBindBuffer(GL_ELEMENT_ARRAY_BUFFER, EBO);

glBufferData(GL_ELEMENT_ARRAY_BUFFER, sizeof(indices), indices, GL_STATIC_DRAW);

// 4. 设定顶点属性指针

glVertexAttribPointer(0, 3, GL_FLOAT, GL_FALSE, 3 * sizeof(float), (void*)0);

glEnableVertexAttribArray(0);

[...]

// ..:: 绘制代码(渲染循环中) :: ..

glUseProgram(shaderProgram);

glBindVertexArray(VAO);

glDrawElements(GL_TRIANGLES, 6, GL_UNSIGNED_INT, 0);

glBindVertexArray(0);

顶点着色器¶

- 创建并编译着色器

//着色器代码

const char *vertexShaderSource = "#version 330 core\n"

"layout (location = 0) in vec3 aPos;\n"

"void main()\n"

"{\n"

" gl_Position = vec4(aPos.x, aPos.y, aPos.z, 1.0);\n"

"}\0";

//创建点着色器,同样用id表示

unsigned int vertexShader;

vertexShader = glCreateShader(GL_VERTEX_SHADER);

//传入并编译着色器(要编译的着色器,字符串树木,字符参数)

glShaderSource(vertexShader, 1, &vertexShaderSource, NULL);

glCompileShader(vertexShader);

- 检查编译错误并输出错误信息

int success;

char infoLog[512];

glGetShaderiv(vertexShader, GL_COMPILE_STATUS, &success);

if(!success)

{

glGetShaderInfoLog(vertexShader, 512, NULL, infoLog);

std::cout << "ERROR::SHADER::VERTEX::COMPILATION_FAILED\n" << infoLog << std::endl;

}

片段着色器¶

- 创建与编译与点着色器同理

const char* fragmentShaderSource = "#version 330 core\n"

"out vec4 FragColor;\n"

"void main()\n"

"{\n"

" FragColor = vec4(1.0f, 0.5f, 0.2f, 1.0f);\n"

"}\n\0";

unsigned int fragmentShader;

fragmentShader = glCreateShader(GL_FRAGMENT_SHADER);

glShaderSource(fragmentShader, 1, &fragmentShaderSource, NULL);

glCompileShader(fragmentShader);

链接着色器¶

- 将编译好的着色器对象链接到用于渲染的程序对象

//创建着色器

unsigned int shaderProgram;

shaderProgram = glCreateProgram();

//附加编译好的着色器

glAttachShader(shaderProgram, vertexShader);

glAttachShader(shaderProgram, fragmentShader);

//链接

glLinkProgram(shaderProgram);

//同样可以检查是否成功

glGetProgramiv(shaderProgram, GL_LINK_STATUS, &success);

if(!success) {

glGetProgramInfoLog(shaderProgram, 512, NULL, infoLog);

...

}

- 创建好之后激活程序对象

glUseProgram(shaderProgram); - 之后每个着色器调用和渲染调用都会使用这个程序对象

- 创建之后可以释放之前的着色器对象

glDeleteShader(vertexShader); glDeleteShader(fragmentShader);

计算着色器¶

- 计算着色器是一种独立于传统渲染管线的 GPU 程序

- 可以直接访问和修改图像、缓冲区数据

- 适合执行通用的计算任务,如图像处理、物理模拟、人工智能推理、数学运算等

- 常见用途:图像处理;粒子系统模拟;物理计算;神经网络推理;数据处理

工作组¶

- 计算着色器的执行模型基于 工作组,这是 GPU 并行计算的基本单位。

- 计算着色器的执行由大量线程组成,称为 全局工作项。

- 全局工作项被分割为若干 工作组,而每个工作组又包含多个 局部工作项

- 着色器中指定工作组的大小

layout(local_size_x = 16, local_size_y = 16) in;即定义了一个 16x16 的工作组,即每个工作组包含 256 个线程。 - 在全局工作项中指定工作组的数目

glDispatchCompute(num_groups_x, num_groups_y, num_groups_z); - 每个着色器可以通过内置变量得到其在本地工作组中的相对坐标,从而确定自己的分工

设置缓冲区¶

- 通过 VBO 顶点缓冲对象管理存储顶点数据的内存(由 cpu 发送到 gpu 并存储在显存中),之后顶点着色器就能迅速访问显存中的顶点数据

//定义顶点坐标 float vertices[] = { -0.5f, -0.5f, 0.0f, 0.5f, -0.5f, 0.0f, 0.0f, 0.5f, 0.0f }; //存储缓冲区对象id unsigned int VBO; //生成缓冲区对象并获取id glGenBuffers(1, &VBO); //将缓冲对象绑定到上下文,作为数组缓冲区 glBindBuffer(GL_ARRAY_BUFFER, VBO); //复制数据到缓冲区 glBufferData(GL_ARRAY_BUFFER, sizeof(vertices), vertices, GL_STATIC_DRAW); - 复制数据的选项:

- GL_STATIC_DRAW :数据不会或几乎不会改变。

- GL_DYNAMIC_DRAW:数据会被改变很多。

- GL_STREAM_DRAW :数据每次绘制时都会改变。

完整代码¶

#include <glad\glad.h>

#include <GLFW\glfw3.h>

#include <iostream>

void framebuffer_size_callback(GLFWwindow* window, int width, int height)

{

glViewport(0, 0, width, height);

}

void processInput(GLFWwindow* window)

{

if (glfwGetKey(window, GLFW_KEY_ESCAPE) == GLFW_PRESS)

glfwSetWindowShouldClose(window, true);

}

int main()

{

//参数设置

glfwInit();

glfwWindowHint(GLFW_CONTEXT_VERSION_MAJOR, 3);

glfwWindowHint(GLFW_CONTEXT_VERSION_MINOR, 3);

glfwWindowHint(GLFW_OPENGL_PROFILE, GLFW_OPENGL_CORE_PROFILE);

//创建上下文

GLFWwindow* window = glfwCreateWindow(800, 600, "LearnOpenGL", NULL, NULL);

if (window == NULL)

{

std::cout << "Failed to create GLFW window" << std::endl;

glfwTerminate();

return -1;

}

glfwMakeContextCurrent(window);

//板顶函数

if (!gladLoadGLLoader((GLADloadproc)glfwGetProcAddress))

{

std::cout << "Failed to initialize GLAD" << std::endl;

return -1;

}

//设置视口大小

glfwSetFramebufferSizeCallback(window, framebuffer_size_callback);

float vertices[] = {

0.5f, 0.5f, 0.0f, // 右上角

0.5f, -0.5f, 0.0f, // 右下角

-0.5f, -0.5f, 0.0f, // 左下角

-0.5f, 0.5f, 0.0f // 左上角

};

unsigned int indices[] = {

// 注意索引从0开始!

// 此例的索引(0,1,2,3)就是顶点数组vertices的下标,

// 这样可以由下标代表顶点组合成矩形

0, 1, 3, // 第一个三角形

1, 2, 3 // 第二个三角形

};

unsigned int VAO;

glGenVertexArrays(1, &VAO);

glBindVertexArray(VAO);

//存储缓冲区对象id

unsigned int VBO;

//生成缓冲区对象并获取id

glGenBuffers(1, &VBO);

//将缓冲对象绑定到上下文,作为数组缓冲区

glBindBuffer(GL_ARRAY_BUFFER, VBO);

//复制数据到缓冲区

glBufferData(GL_ARRAY_BUFFER, sizeof(vertices), vertices, GL_STATIC_DRAW);

unsigned int EBO;

glGenBuffers(1, &EBO);

glBindBuffer(GL_ELEMENT_ARRAY_BUFFER, EBO);

glBufferData(GL_ELEMENT_ARRAY_BUFFER, sizeof(indices), indices, GL_STATIC_DRAW);

const char* vertexShaderSource = "#version 330 core\n"

"layout (location = 0) in vec3 aPos;\n"

"void main()\n"

"{\n"

" gl_Position = vec4(aPos.x, aPos.y, aPos.z, 1.0);\n"

"}\0";

//创建点着色器,同样用id表示

unsigned int vertexShader;

vertexShader = glCreateShader(GL_VERTEX_SHADER);

//传入并编译着色器

glShaderSource(vertexShader, 1, &vertexShaderSource, NULL);

glCompileShader(vertexShader);

int success;

char infoLog[512];

glGetShaderiv(vertexShader, GL_COMPILE_STATUS, &success);

if (!success)

{

glGetShaderInfoLog(vertexShader, 512, NULL, infoLog);

std::cout << "ERROR::SHADER::VERTEX::COMPILATION_FAILED\n" << infoLog << std::endl;

}

const char* fragmentShaderSource = "#version 330 core\n"

"out vec4 FragColor;\n"

"void main()\n"

"{\n"

" FragColor = vec4(1.0f, 0.5f, 0.2f, 1.0f);\n"

"}\n\0";

unsigned int fragmentShader;

fragmentShader = glCreateShader(GL_FRAGMENT_SHADER);

glShaderSource(fragmentShader, 1, &fragmentShaderSource, NULL);

glCompileShader(fragmentShader);

unsigned int shaderProgram;

shaderProgram = glCreateProgram();

glAttachShader(shaderProgram, vertexShader);

glAttachShader(shaderProgram, fragmentShader);

glLinkProgram(shaderProgram);

glUseProgram(shaderProgram);

glDeleteShader(vertexShader);

glDeleteShader(fragmentShader);

glVertexAttribPointer(0, 3, GL_FLOAT, GL_FALSE, 3 * sizeof(float), (void*)0);

glEnableVertexAttribArray(0);

while (!glfwWindowShouldClose(window))

{

// 输入

processInput(window);

// 渲染指令

glClearColor(0.2f, 0.3f, 0.3f, 1.0f);

glClear(GL_COLOR_BUFFER_BIT);

glUseProgram(shaderProgram);

glBindVertexArray(VAO);

glDrawElements(GL_TRIANGLES, 6, GL_UNSIGNED_INT, 0);

glBindVertexArray(0);

// 检查并调用事件,交换缓冲

glfwSwapBuffers(window);

glfwPollEvents();

}

//释放资源

glfwTerminate();

return 0;

}

缓存¶

- 常见的缓存:颜色缓存;深度缓存;模板缓存

清除缓存¶

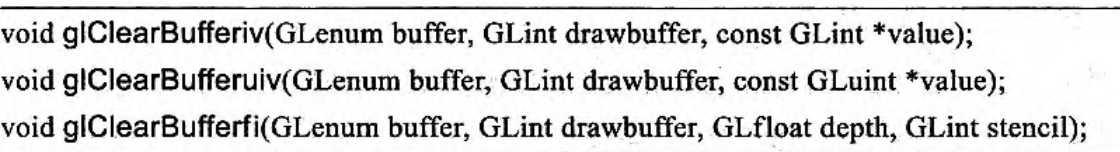

- 清除缓存:

void glClearBufferfv(GLenum buffer,GLint drawbuffer,const GLfloat *value);- 清除地缓存(如 GL_COLOR)

- 处理多个颜色缓冲的情况

- 清除后的初始值

- 清除不同的数据类型

- 如用

glClearBufferiv清除整数数据模板缓存

glClearBufferfi()可以同时清除深度和模板缓存- 采纳数必须为

GL_DEPTH_STENCIL,0

- 采纳数必须为

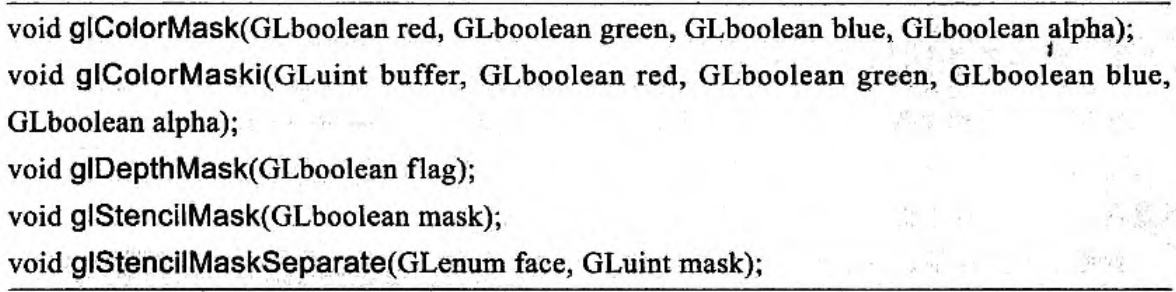

缓存掩码¶

- 在 opengl 向颜色、深度或者模板缓存写入数据之前可以对数据进行一次掩码操作

- 通过 bool 来设置是否允许进行写入(即用 1 进行与还是用 0 进行)

混合¶

- 一个输入的片元通过了测试,就可以与当前颜色缓存中当前内容通过某种方式来进行合并了(直接覆盖现有的值就实现深度缓冲遮挡效果、进行计算就是“融混”)

- 开启混合

glEnable(GL_BLEND);

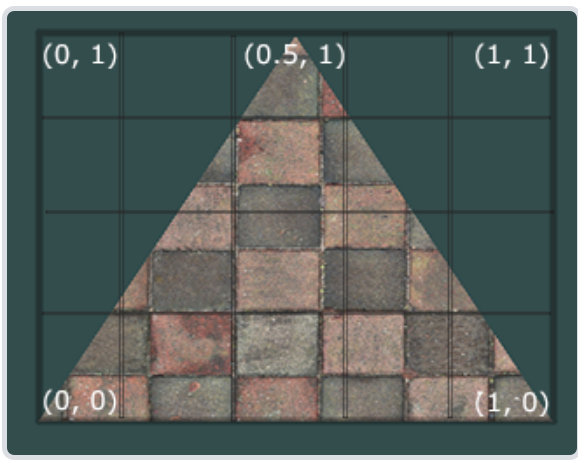

含透明通道贴图¶

- 使用有透明分量的纹理时

glTexImage2D(GL_TEXTURE_2D, 0, GL_RGBA, width, height, 0, GL_RGBA, GL_UNSIGNED_BYTE, data); - 要注意使用

GL_RGBA - 在着色器中可以根据 alpha 的值来判断是否丢弃像素(这个点显示为透明)

void main()

{

vec4 texColor = texture(texture1, TexCoords);

if(texColor.a < 0.1)

discard;

FragColor = texColor;

}

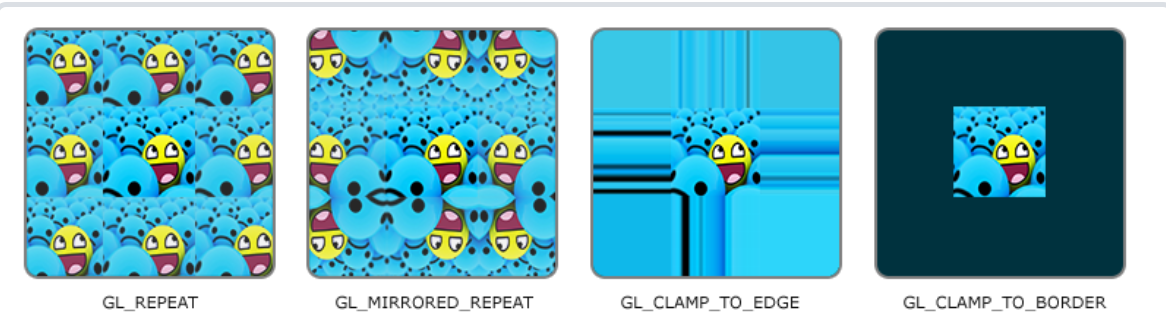

- 要注意的是,如果使用 GL_REPEAT 等环绕方式,由于 OpenGL 会对边缘的值和纹理下一个重复的值进行插值导致边框具有颜色,这就可能产生一个半透明有色边框,对于这种图片就要使用 GL_CLAMP_TO_EDGE 环绕方式

颜色混合¶

- 混合方程 \(\bar{C}_{result}=\bar{C}_{source}*F_{source}+\bar{C}_{destination}*F_{destination}\)

- 颜色 1*源因子值+颜色 2*目标因子值

glBlendFunc(GLenum sfactor, GLenum dfactor)函数接受两个参数,来设置源和目标因子

- 比如使用源的 alpha、1-alpha:

glBlendFunc(GL_SRC_ALPHA, GL_ONE_MINUS_SRC_ALPHA); - 也可以使用

glBlendFuncSeparate来分别设置 RGBA 四个通道 glBlendEquation(GLenum mode)设置颜色的运算方式- GL_FUNC_ADD:默认选项,将两个分量相加

- GL_FUNC_SUBTRACT:将两个分量相减

-

GL_FUNC_REVERSE_SUBTRACT:将两个分量相减,但顺序相反

-

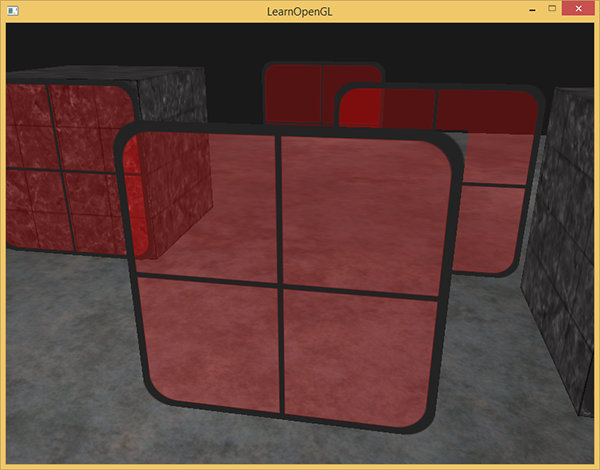

同时使用深度测试和混合会存在问题,导致不该被丢弃的内容被丢弃

- 对于每一个片段,深度测试会比较它的深度值与深度缓冲的当前值。如果深度测试失败该片段会被丢弃,即使当前值所在的贴图是半透明的!这就丢失了数据

-

要想保证窗户中能够显示它们背后的窗户,我们需要首先绘制背后的这部分窗户。这也就是说在绘制的时候,我们必须先手动将窗户按照最远到最近来排序,再按照顺序渲染。

-

使用混合时的渲染原则

- 先绘制所有不透明的物体。

- 对所有透明的物体排序。

-

按顺序绘制所有透明的物体。

-

排序透明物体:观察者视角获取物体的距离,可以通过计算摄像机位置向量和物体的位置向量之间的距离所获得

std::map<float, glm::vec3> sorted;

for (unsigned int i = 0; i < windows.size(); i++)

{

float distance = glm::length(camera.Position - windows[i]);

sorted[distance] = windows[i];

}

- 渲染时直接从 map 读取排好序的

for(std::map<float,glm::vec3>::reverse_iterator it = sorted.rbegin(); it != sorted.rend(); ++it)

{

model = glm::mat4();

model = glm::translate(model, it->second);

shader.setMat4("model", model);

glDrawArrays(GL_TRIANGLES, 0, 6);

}

面剔除¶

-

丢弃背对观察者的面,只渲染面向观察者的面,节省开销

-

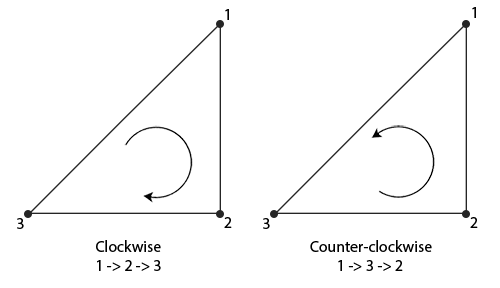

以环绕顺序来定义三角形的顶点

- 全部按照逆时针规则进行定义(对顶点数据的要求)

-

这样从正面看为逆时针的三角形就是面向观察者的面,顺时针的就是背对的面,可以进行剔除

-

启用面剔除:

glEnable(GL_CULL_FACE); - 剔除的面的类型

glCullFace(GL_FRONT); GL_BACK:只剔除背向面。GL_FRONT:只剔除正向面。GL_FRONT_AND_BACK:剔除正向面和背向面。- 正面的方向

glFrontFace(GL_CCW); - GL_CCW 表示逆时针环绕

- GL_CW 表示顺时针环绕

帧缓冲¶

- 颜色缓冲、深度信息缓冲等各种缓冲结合再起来就是帧缓冲,默认的帧缓冲是窗口时生成和配置的

- 帧缓冲是一种容器对象,用于管理多个附件

-

可以用于离屏渲染:将渲染结果输出到纹理或其他附件上而不是直接显示在屏幕

-

创建帧缓冲对象

unsigned int fbo; glGenFramebuffers(1, &fbo); //绑定为当前激活的帧缓冲 glBindFramebuffer(GL_FRAMEBUFFER, fbo); -

绑定帧缓冲之后,所有的读取和写入帧缓冲的操作都会影响绑定的帧缓冲

-

也可以用 GL_READ_FRAMEBUFFER 或 GL_DRAW_FRAMEBUFFER 分别进行绑定

-

完整的帧缓冲:

- 附加至少一个缓冲(颜色、深度或模板缓冲)。

- 至少有一个颜色附件 (Attachment)。

- 所有的附件都必须是完整的(保留了内存)。

- 每个缓冲都应该有相同的样本数 (sample)。

-

检查帧缓冲是否完整

if(glCheckFramebufferStatus(GL_FRAMEBUFFER) == GL_FRAMEBUFFER_COMPLETE) -

之后所有的渲染操作将会渲染到当前绑定帧缓冲的附件中, 要保证所有的渲染操作在主窗口中有视觉效果,我们需要再次激活默认帧缓冲,将它绑定到

0。 glBindFramebuffer(GL_FRAMEBUFFER, 0);

纹理附件¶

-

可以直接采样,适合需要后续处理的情况

-

当把一个纹理附加到帧缓冲的时候,所有的渲染指令将会写入到这个纹理中,所有渲染操作的结果将会被储存在一个纹理图像中

unsigned int texture;

glGenTextures(1, &texture);

glBindTexture(GL_TEXTURE_2D, texture);

//只分配空间,并没有设置纹理数据

glTexImage2D(GL_TEXTURE_2D, 0, GL_RGB, 800, 600, 0, GL_RGB, GL_UNSIGNED_BYTE, NULL);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_MIN_FILTER, GL_LINEAR);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_MAG_FILTER, GL_LINEAR);

glFramebufferTexture2D(GL_FRAMEBUFFER, GL_COLOR_ATTACHMENT0, GL_TEXTURE_2D, texture, 0);

//创建一个深度&模板缓冲的纹理(正好24+8=32)

glTexImage2D(

GL_TEXTURE_2D, 0, GL_DEPTH24_STENCIL8, 800, 600, 0,

GL_DEPTH_STENCIL, GL_UNSIGNED_INT_24_8, NULL

);

glFramebufferTexture2D(GL_FRAMEBUFFER, GL_DEPTH_STENCIL_ATTACHMENT, GL_TEXTURE_2D, texture, 0);

- 将纹理附加到帧缓冲

glFramebufferTexture2D(GL_FRAMEBUFFER, GL_COLOR_ATTACHMENT0, GL_TEXTURE_2D, texture, 0); target:帧缓冲的目标(绘制、读取或者两者皆有)attachment:我们想要附加的附件类型。当前我们正在附加一个颜色附件。注意最后的0意味着我们可以附加多个颜色附件。我们将在之后的教程中提到。textarget:你希望附加的纹理类型texture:要附加的纹理本身level:多级渐远纹理的级别。我们将它保留为 0。

渲染缓冲对象附件¶

- 用于存储渲染过程中生成的数据,不能直接采样,主要用于中间渲染结果的存储,实际存储了渲染数据

- 直接将多有的渲染数据存储到缓冲中,不进行任何转换,效率很高

- 渲染缓冲对象通常都是只写的:不能采样(通过纹理坐标进行访问),但是可以将数据复制到纹理再进行访问

unsigned int rbo;

glGenRenderbuffers(1, &rbo);

//绑定帧缓冲对象

glBindRenderbuffer(GL_RENDERBUFFER, rbo);

//为渲染缓冲对象分配存储空间

glRenderbufferStorage(GL_RENDERBUFFER, GL_DEPTH24_STENCIL8, 800, 600);

//将渲染缓冲对象附加到帧缓冲对象

glFramebufferRenderbuffer(GL_FRAMEBUFFER, GL_DEPTH_STENCIL_ATTACHMENT, GL_RENDERBUFFER, rbo);

渲染到纹理¶

- 将一个场景附加到帧缓冲对象上的颜色纹理并在图形上绘制这个纹理

//创建帧缓冲对象

unsigned int framebuffer;

glGenFramebuffers(1, &framebuffer);

glBindFramebuffer(GL_FRAMEBUFFER, framebuffer);

// 生成纹理(颜色纹理需要采样、显示,因此使用纹理附件)

unsigned int texColorBuffer;

glGenTextures(1, &texColorBuffer);

glBindTexture(GL_TEXTURE_2D, texColorBuffer);

glTexImage2D(GL_TEXTURE_2D, 0, GL_RGB, 800, 600, 0, GL_RGB, GL_UNSIGNED_BYTE, NULL);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_MIN_FILTER, GL_LINEAR );

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_MAG_FILTER, GL_LINEAR);

glBindTexture(GL_TEXTURE_2D, 0);

// 将它附加到当前绑定的帧缓冲对象

glFramebufferTexture2D(GL_FRAMEBUFFER, GL_COLOR_ATTACHMENT0, GL_TEXTURE_2D, texColorBuffer, 0);

//深度、模板缓冲不需要采样,因此使用帧缓冲对象

unsigned int rbo;

glGenRenderbuffers(1, &rbo);

glBindRenderbuffer(GL_RENDERBUFFER, rbo);

glRenderbufferStorage(GL_RENDERBUFFER, GL_DEPTH24_STENCIL8, 800, 600);

glBindRenderbuffer(GL_RENDERBUFFER, 0);

glFramebufferRenderbuffer(GL_FRAMEBUFFER, GL_DEPTH_STENCIL_ATTACHMENT, GL_RENDERBUFFER, rbo);

//检查是否完整

if(glCheckFramebufferStatus(GL_FRAMEBUFFER) != GL_FRAMEBUFFER_COMPLETE)

std::cout << "ERROR::FRAMEBUFFER:: Framebuffer is not complete!" << std::endl;

//接下来将新的帧缓冲绑定为激活的帧缓冲

glBindFramebuffer(GL_FRAMEBUFFER, 0);

- 离屏渲染

glBindFramebuffer(GL_FRAMEBUFFER, framebuffer); // 绑定自定义帧缓冲

glClearColor(0.1f, 0.1f, 0.1f, 1.0f); // 设置清屏颜色

glClear(GL_COLOR_BUFFER_BIT | GL_DEPTH_BUFFER_BIT); // 清空颜色缓冲和深度缓冲

glEnable(GL_DEPTH_TEST); // 启用深度测试

DrawScene(); // 渲染场景

- 屏幕渲染

glBindFramebuffer(GL_FRAMEBUFFER, 0); // 绑定默认帧缓冲(屏幕帧缓冲)

glClearColor(1.0f, 1.0f, 1.0f, 1.0f); // 设置屏幕清屏颜色为白色

glClear(GL_COLOR_BUFFER_BIT); // 清空屏幕的颜色缓冲

screenShader.use(); // 使用屏幕渲染的着色器

glBindVertexArray(quadVAO); // 绑定渲染屏幕四边形的VAO

glDisable(GL_DEPTH_TEST); // 禁用深度测试

glBindTexture(GL_TEXTURE_2D, textureColorbuffer);// 绑定第一阶段的颜色缓冲纹理

glDrawArrays(GL_TRIANGLES, 0, 6); // 绘制屏幕四边形

后期处理¶

- 可以在离屏渲染后,切换使用后期处理着色器,即实现在屏幕渲染阶段的后期处理

- 此时可以实现很多效果,因为可以获得一个像素及其周边像素的数据 (核采样时要小心环绕扩展方式造成的影响)

- 如模糊效果 \(\begin{bmatrix}1&2&1\\2&4&2\\1&2&1\end{bmatrix}/16\)

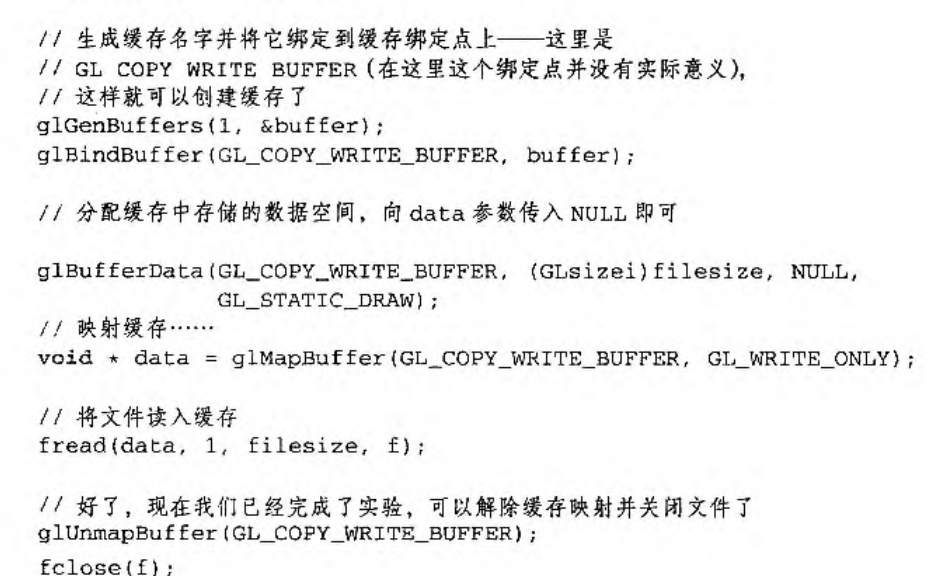

高级数据¶

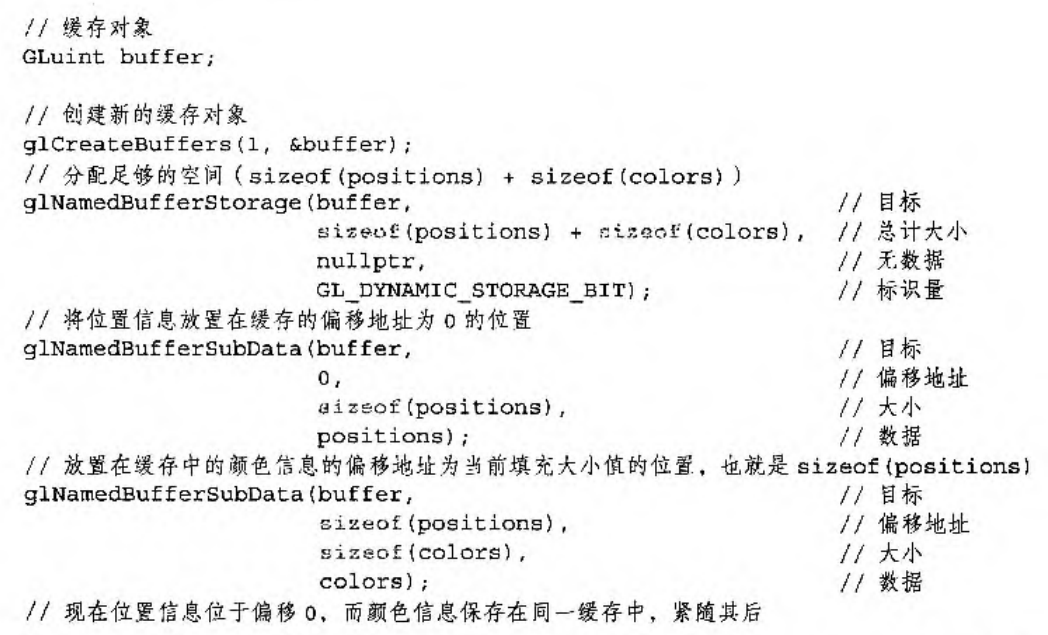

- 通过

glBufferData可以创建缓冲对象,并用数据立即进行填充 - 也可以通过

glBufferSubData来填充特定的缓冲区域 glBufferSubData(GL_ARRAY_BUFFER, 24, sizeof(data), &data);- 缓冲目标、偏移量、数据大小、数据源

- 要保证缓冲区有足够大的内存

- 也可以直接

void *ptr = glMapBuffer(GL_ARRAY_BUFFER, GL_WRITE_ONLY);获取缓冲区内存的指针,再通过memcpy等直接修改缓冲区的内容 -

释放指针

glUnmapBuffer(GL_ARRAY_BUFFER); -

除了使用类似结构体那样交替存储顶点数据(123123123123),采用分批的方式进行存储(111122223333)

- 有时获得的时这种分批方式存储的数据

float positions[] = { ... };

float normals[] = { ... };

float tex[] = { ... };

// 填充缓冲

glBufferSubData(GL_ARRAY_BUFFER, 0, sizeof(positions), &positions);

glBufferSubData(GL_ARRAY_BUFFER, sizeof(positions), sizeof(normals), &normals);

glBufferSubData(GL_ARRAY_BUFFER, sizeof(positions) + sizeof(normals), sizeof(tex), &tex);

//绑定

glVertexAttribPointer(0, 3, GL_FLOAT, GL_FALSE, 3 * sizeof(float), 0);

glVertexAttribPointer(1, 3, GL_FLOAT, GL_FALSE, 3 * sizeof(float), (void*)(sizeof(positions)));

glVertexAttribPointer(

2, 2, GL_FLOAT, GL_FALSE, 2 * sizeof(float), (void*)(sizeof(positions) + sizeof(normals)));

- 复制缓冲

void glCopyBufferSubData(GLenum readtarget, GLenum writetarget, GLintptr readoffset, GLintptr writeoffset, GLsizeiptr size); readtarget和writetarget参数需要填入复制源和复制目标的缓冲目标。比如说,我们可以将 VERTEX_ARRAY_BUFFER 缓冲复制到 VERTEX_ELEMENT_ARRAY_BUFFER缓冲- 也可以使用提供的专供复制的 GL_COPY_READ_BUFFER 和 GL_COPY_WRITE_BUFFER

float vertexData[] = { ... };

glBindBuffer(GL_COPY_READ_BUFFER, vbo1);

glBindBuffer(GL_COPY_WRITE_BUFFER, vbo2);

glCopyBufferSubData(GL_COPY_READ_BUFFER, GL_COPY_WRITE_BUFFER, 0, 0, sizeof(vertexData));

变换¶

坐标系统¶

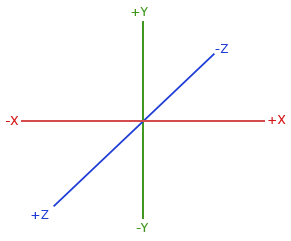

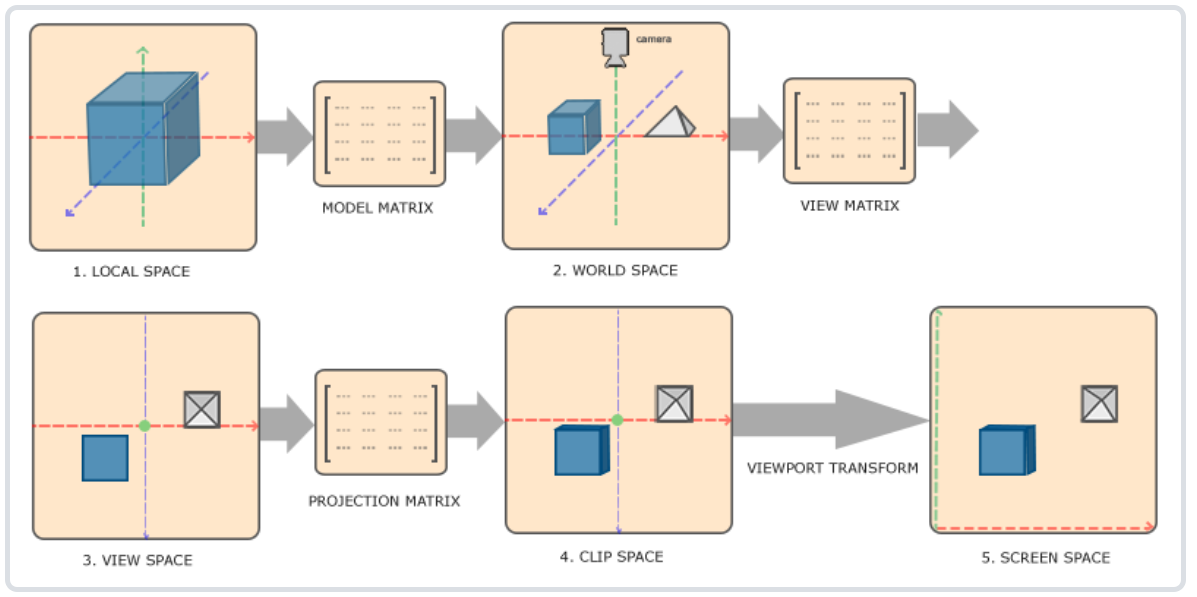

- 局部空间(Local Space):对象相对于局部原点的坐标

- 适合对物体自身进行操作 (如调整模型)

- 通过模型矩阵转换

- 世界空间(World Space):相当于世界的全局原点

- 物体之间的位置关系,对物体进行移动、缩放、旋转等,场景布置

- 通过观察矩阵转换

- 观察空间(View Space):从摄像机/观察者角度观察

- opengl 本身没有摄像机的概念,通过相反移动物体来实现模拟摄像机

-

通过投影矩阵转换

-

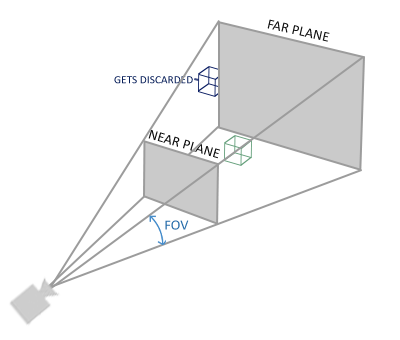

裁剪空间(Clip Space):裁剪到 -1~1 的范围

- 将大范围坐标转化到小范围,比如在每个维度上的-1000 到 1000。投影矩阵接着会将在这个指定的范围内的坐标变换为标准化设备坐标的范围 (-1.0, 1.0)。所有在范围外的坐标不会被映射到在-1.0 到 1.0 的范围之间,所以会被裁剪掉。

- 裁剪之后进行投影映射到屏幕空间

-

屏幕空间(Screen Space):屏幕上的坐标

-

正交投影

- 可以使用 glm 创建投影矩阵

glm::ortho(0.0f, 800.0f, 0.0f, 600.0f, 0.1f, 100.0f); - 参数给出了宽度,长度,远近平面的范围

- 主要用于二维渲染、建筑工程

- 透视投影

glm::mat4 proj = glm::perspective(glm::radians(45.0f), (float)width/(float)height, 0.1f, 100.0f);- 参数给出 fov 视野角度,宽高比,远近平面

-

-

完整的变换 \(V_{clip}=M_{projection}\cdot M_{view}\cdot M_{model}\cdot V_{local}\)

- 着色器中

gl_Position = projection * view * model * vec4(aPos, 1.0);

摄像机¶

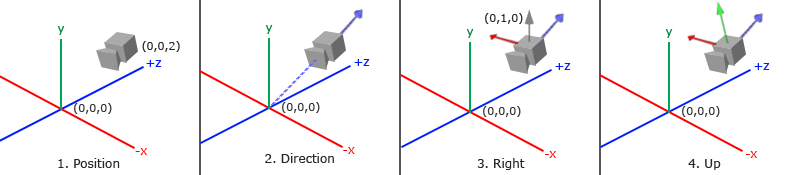

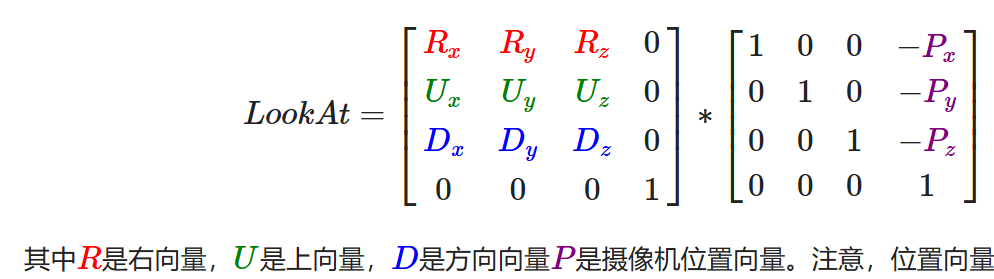

- 通过构建摄像机三维坐标系矩阵,来对物体进行变换

- 首先摄像机的坐标

glm::vec3 cameraPos = glm::vec3(0.0f, 0.0f, 3.0f); - 结合指向计算得到摄像机指向(反方向,图中蓝色)

glm::vec3 cameraTarget = glm::vec3(0.0f, 0.0f, 0.0f);

glm::vec3 cameraDirection = glm::normalize(cameraPos - cameraTarget);

- 右轴:摄像机空间的 x 轴正方向

- 通过定义上向量,与指向叉乘就可以得到右轴

glm::vec3 up = glm::vec3(0.0f, 1.0f, 0.0f);

glm::vec3 cameraRight = glm::normalize(glm::cross(up, cameraDirection));

- 上轴:摄像机空间的 y 轴正方向

-

可以由另外两个轴计算得到

glm::vec3 cameraUp = glm::cross(cameraDirection, cameraRight); -

用这三个向量,和摄像机坐标就能构建变换矩阵 Lookat 矩阵

- 只需要提供摄像机位置、目标位置、上向量就可以用 glm 创建出 lookat 矩阵

glm::mat4 view;

view = glm::lookAt(glm::vec3(0.0f, 0.0f, 3.0f),

glm::vec3(0.0f, 0.0f, 0.0f),

glm::vec3(0.0f, 1.0f, 0.0f));

- 实现一个简单的摄像机环绕

float radius = 10.0f;

float camX = sin(glfwGetTime()) * radius;

float camZ = cos(glfwGetTime()) * radius;

glm::mat4 view;

view = glm::lookAt(glm::vec3(camX, 0.0, camZ), glm::vec3(0.0, 0.0, 0.0), glm::vec3(0.0, 1.0, 0.0));

平移¶

- 要想实现平移效果,可以让目标点与摄像机坐标相关,比如始终值指向前面

glm::vec3 cameraPos = glm::vec3(0.0f, 0.0f, 3.0f);

glm::vec3 cameraFront = glm::vec3(0.0f, 0.0f, -1.0f);

glm::vec3 cameraUp = glm::vec3(0.0f, 1.0f, 0.0f);

view = glm::lookAt(cameraPos, cameraPos + cameraFront, cameraUp);

//用键盘来控制移动

void processInput(GLFWwindow* window)

{

if (glfwGetKey(window, GLFW_KEY_ESCAPE) == GLFW_PRESS)

glfwSetWindowShouldClose(window, true);

float cameraSpeed = 0.05f; // adjust accordingly

if (glfwGetKey(window, GLFW_KEY_W) == GLFW_PRESS)

cameraPos += cameraSpeed * cameraFront;

if (glfwGetKey(window, GLFW_KEY_S) == GLFW_PRESS)

cameraPos -= cameraSpeed * cameraFront;

if (glfwGetKey(window, GLFW_KEY_A) == GLFW_PRESS)

cameraPos -= glm::normalize(glm::cross(cameraFront, cameraUp)) * cameraSpeed;

if (glfwGetKey(window, GLFW_KEY_D) == GLFW_PRESS)

cameraPos += glm::normalize(glm::cross(cameraFront, cameraUp)) * cameraSpeed;

}

- 左右移动方向是根据叉乘再标准化得到的

- 注意这种移动速度和刷新率相关,想要恒定速度要计算时间

旋转¶

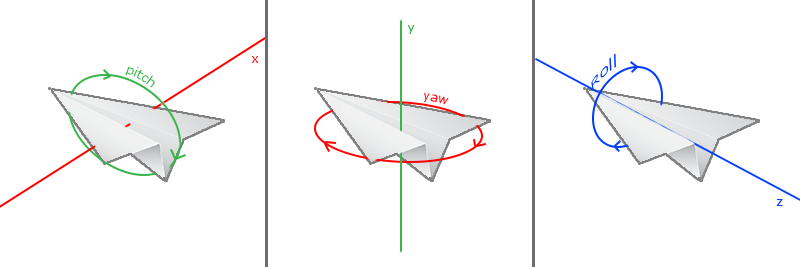

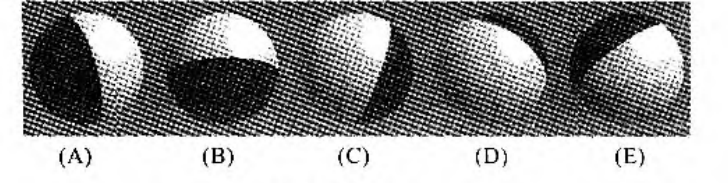

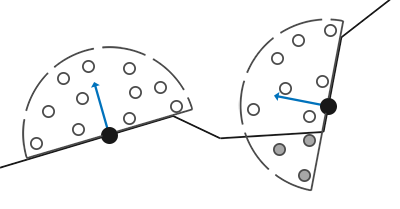

- 三种旋转角:俯仰角、偏航角、滚转角

-

-

通过鼠标输入实现旋转控制:水平的移动影响偏航角,竖直的移动影响俯仰角

-

通过比较两帧之间坐标差距,决定角度的偏移

-

捕捉光标,在窗口内不显示(但是记录位置用于操控)

glfwSetInputMode(window, GLFW_CURSOR, GLFW_CURSOR_DISABLED); -

注册监听

glfwSetCursorPosCallback(window, mouse_callback);

void mouse_callback(GLFWwindow* window, double xpos, double ypos) {

if (firstMouse)

{

lastX = xpos;

lastY = ypos;

firstMouse = false;

}

float xoffset = xpos - lastX;

float yoffset = lastY - ypos;

lastX = xpos;

lastY = ypos;

float sensitivity = 0.05;

xoffset *= sensitivity;

yoffset *= sensitivity;

yaw += xoffset;

pitch += yoffset;

if (pitch > 89.0f)

pitch = 89.0f;

if (pitch < -89.0f)

pitch = -89.0f;

glm::vec3 front;

front.x = cos(glm::radians(yaw)) * cos(glm::radians(pitch));

front.y = sin(glm::radians(pitch));

front.z = sin(glm::radians(yaw)) * cos(glm::radians(pitch));

cameraFront = glm::normalize(front);

}

缩放¶

- 通过监听滚轮调整 fov 来实现¶

示例:摄像机类¶

#ifndef CAMERA_H

#define CAMERA_H

#include <glad/glad.h>

#include <glm/glm.hpp>

#include <glm/gtc/matrix_transform.hpp>

// Defines several possible options for camera movement. Used as abstraction to stay away from window-system specific input methods

enum Camera_Movement {

FORWARD,

BACKWARD,

LEFT,

RIGHT

};

// Default camera values

const float YAW = -90.0f;

const float PITCH = 0.0f;

const float SPEED = 2.5f;

const float SENSITIVITY = 0.1f;

const float ZOOM = 45.0f;

// An abstract camera class that processes input and calculates the corresponding Euler Angles, Vectors and Matrices for use in OpenGL

class Camera

{

public:

// camera Attributes

glm::vec3 Position;

glm::vec3 Front;

glm::vec3 Up;

glm::vec3 Right;

glm::vec3 WorldUp;

// euler Angles

float Yaw;

float Pitch;

// camera options

float MovementSpeed;

float MouseSensitivity;

float Zoom;

// constructor with vectors

Camera(glm::vec3 position = glm::vec3(0.0f, 0.0f, 0.0f), glm::vec3 up = glm::vec3(0.0f, 1.0f, 0.0f), float yaw = YAW, float pitch = PITCH) : Front(glm::vec3(0.0f, 0.0f, -1.0f)), MovementSpeed(SPEED), MouseSensitivity(SENSITIVITY), Zoom(ZOOM)

{

Position = position;

WorldUp = up;

Yaw = yaw;

Pitch = pitch;

updateCameraVectors();

}

// constructor with scalar values

Camera(float posX, float posY, float posZ, float upX, float upY, float upZ, float yaw, float pitch) : Front(glm::vec3(0.0f, 0.0f, -1.0f)), MovementSpeed(SPEED), MouseSensitivity(SENSITIVITY), Zoom(ZOOM)

{

Position = glm::vec3(posX, posY, posZ);

WorldUp = glm::vec3(upX, upY, upZ);

Yaw = yaw;

Pitch = pitch;

updateCameraVectors();

}

// returns the view matrix calculated using Euler Angles and the LookAt Matrix

glm::mat4 GetViewMatrix()

{

return glm::lookAt(Position, Position + Front, Up);

}

// processes input received from any keyboard-like input system. Accepts input parameter in the form of camera defined ENUM (to abstract it from windowing systems)

void ProcessKeyboard(Camera_Movement direction, float deltaTime)

{

float velocity = MovementSpeed * deltaTime;

if (direction == FORWARD)

Position += Front * velocity;

if (direction == BACKWARD)

Position -= Front * velocity;

if (direction == LEFT)

Position -= Right * velocity;

if (direction == RIGHT)

Position += Right * velocity;

}

// processes input received from a mouse input system. Expects the offset value in both the x and y direction.

void ProcessMouseMovement(float xoffset, float yoffset, GLboolean constrainPitch = true)

{

xoffset *= MouseSensitivity;

yoffset *= MouseSensitivity;

Yaw += xoffset;

Pitch += yoffset;

// make sure that when pitch is out of bounds, screen doesn't get flipped

if (constrainPitch)

{

if (Pitch > 89.0f)

Pitch = 89.0f;

if (Pitch < -89.0f)

Pitch = -89.0f;

}

// update Front, Right and Up Vectors using the updated Euler angles

updateCameraVectors();

}

// processes input received from a mouse scroll-wheel event. Only requires input on the vertical wheel-axis

void ProcessMouseScroll(float yoffset)

{

Zoom -= (float)yoffset;

if (Zoom < 1.0f)

Zoom = 1.0f;

if (Zoom > 45.0f)

Zoom = 45.0f;

}

private:

// calculates the front vector from the Camera's (updated) Euler Angles

void updateCameraVectors()

{

// calculate the new Front vector

glm::vec3 front;

front.x = cos(glm::radians(Yaw)) * cos(glm::radians(Pitch));

front.y = sin(glm::radians(Pitch));

front.z = sin(glm::radians(Yaw)) * cos(glm::radians(Pitch));

Front = glm::normalize(front);

// also re-calculate the Right and Up vector

Right = glm::normalize(glm::cross(Front, WorldUp)); // normalize the vectors, because their length gets closer to 0 the more you look up or down which results in slower movement.

Up = glm::normalize(glm::cross(Right, Front));

}

};

#endif

1

- 程序代码

#include "shader.h"

#include "camera.h"

#define STB_IMAGE_IMPLEMENTATION

#include "stb_image.h"

#include <glad\glad.h>

#include <GLFW\glfw3.h>

#include <iostream>

#include <glm/glm.hpp>

#include <glm/gtc/matrix_transform.hpp>

#include <glm/gtc/type_ptr.hpp>

glm::vec3 cameraPos = glm::vec3(0.0f, 0.0f, 3.0f);

glm::vec3 cameraFront = glm::vec3(0.0f, 0.0f, -1.0f);

glm::vec3 cameraUp = glm::vec3(0.0f, 1.0f, 0.0f);

float screenWidth = 800;

float screenHeight = 600;

float lastX = screenWidth/2, lastY = screenHeight/2;

float deltaTime = 0.0f;

float lastFrame = 0.0f;

bool firstMouse = true;

Camera camera(glm::vec3(0.0f, 0.0f, 3.0f));

void framebuffer_size_callback(GLFWwindow* window, int width, int height)

{

glViewport(0, 0, width, height);

}

void processInput(GLFWwindow* window)

{

if (glfwGetKey(window, GLFW_KEY_ESCAPE) == GLFW_PRESS)

glfwSetWindowShouldClose(window, true);

if (glfwGetKey(window, GLFW_KEY_W) == GLFW_PRESS)

camera.ProcessKeyboard(FORWARD, deltaTime);

if (glfwGetKey(window, GLFW_KEY_S) == GLFW_PRESS)

camera.ProcessKeyboard(BACKWARD, deltaTime);

if (glfwGetKey(window, GLFW_KEY_A) == GLFW_PRESS)

camera.ProcessKeyboard(LEFT, deltaTime);

if (glfwGetKey(window, GLFW_KEY_D) == GLFW_PRESS)

camera.ProcessKeyboard(RIGHT, deltaTime);

}

void mouse_callback(GLFWwindow* window, double xpos, double ypos) {

if (firstMouse)

{

lastX = xpos;

lastY = ypos;

firstMouse = false;

}

float xoffset = xpos - lastX;

float yoffset = lastY - ypos;

lastX = xpos;

lastY = ypos;

camera.ProcessMouseMovement(xoffset, yoffset);

}

void scroll_callback(GLFWwindow* window, double xoffset, double yoffset)

{

camera.ProcessMouseScroll(static_cast<float>(yoffset));

}

int main()

{

//参数设置

glfwInit();

glfwWindowHint(GLFW_CONTEXT_VERSION_MAJOR, 3);

glfwWindowHint(GLFW_CONTEXT_VERSION_MINOR, 3);

glfwWindowHint(GLFW_OPENGL_PROFILE, GLFW_OPENGL_CORE_PROFILE);

//创建上下文

GLFWwindow* window = glfwCreateWindow(screenWidth, screenHeight, "LearnOpenGL", NULL, NULL);

if (window == NULL)

{

std::cout << "Failed to create GLFW window" << std::endl;

glfwTerminate();

return -1;

}

glfwMakeContextCurrent(window);

//板顶函数

if (!gladLoadGLLoader((GLADloadproc)glfwGetProcAddress))

{

std::cout << "Failed to initialize GLAD" << std::endl;

return -1;

}

//设置视口大小

glfwSetFramebufferSizeCallback(window, framebuffer_size_callback);

glfwSetCursorPosCallback(window, mouse_callback);

glfwSetScrollCallback(window, scroll_callback);

float vertices[] = {

-0.5f, -0.5f, -0.5f, 0.0f, 0.0f,

0.5f, -0.5f, -0.5f, 1.0f, 0.0f,

0.5f, 0.5f, -0.5f, 1.0f, 1.0f,

0.5f, 0.5f, -0.5f, 1.0f, 1.0f,

-0.5f, 0.5f, -0.5f, 0.0f, 1.0f,

-0.5f, -0.5f, -0.5f, 0.0f, 0.0f,

-0.5f, -0.5f, 0.5f, 0.0f, 0.0f,

0.5f, -0.5f, 0.5f, 1.0f, 0.0f,

0.5f, 0.5f, 0.5f, 1.0f, 1.0f,

0.5f, 0.5f, 0.5f, 1.0f, 1.0f,

-0.5f, 0.5f, 0.5f, 0.0f, 1.0f,

-0.5f, -0.5f, 0.5f, 0.0f, 0.0f,

-0.5f, 0.5f, 0.5f, 1.0f, 0.0f,

-0.5f, 0.5f, -0.5f, 1.0f, 1.0f,

-0.5f, -0.5f, -0.5f, 0.0f, 1.0f,

-0.5f, -0.5f, -0.5f, 0.0f, 1.0f,

-0.5f, -0.5f, 0.5f, 0.0f, 0.0f,

-0.5f, 0.5f, 0.5f, 1.0f, 0.0f,

0.5f, 0.5f, 0.5f, 1.0f, 0.0f,

0.5f, 0.5f, -0.5f, 1.0f, 1.0f,

0.5f, -0.5f, -0.5f, 0.0f, 1.0f,

0.5f, -0.5f, -0.5f, 0.0f, 1.0f,

0.5f, -0.5f, 0.5f, 0.0f, 0.0f,

0.5f, 0.5f, 0.5f, 1.0f, 0.0f,

-0.5f, -0.5f, -0.5f, 0.0f, 1.0f,

0.5f, -0.5f, -0.5f, 1.0f, 1.0f,

0.5f, -0.5f, 0.5f, 1.0f, 0.0f,

0.5f, -0.5f, 0.5f, 1.0f, 0.0f,

-0.5f, -0.5f, 0.5f, 0.0f, 0.0f,

-0.5f, -0.5f, -0.5f, 0.0f, 1.0f,

-0.5f, 0.5f, -0.5f, 0.0f, 1.0f,

0.5f, 0.5f, -0.5f, 1.0f, 1.0f,

0.5f, 0.5f, 0.5f, 1.0f, 0.0f,

0.5f, 0.5f, 0.5f, 1.0f, 0.0f,

-0.5f, 0.5f, 0.5f, 0.0f, 0.0f,

-0.5f, 0.5f, -0.5f, 0.0f, 1.0f

};

glm::vec3 cubePositions[] = {

glm::vec3(0.0f, 0.0f, 0.0f),

glm::vec3(2.0f, 5.0f, -15.0f),

glm::vec3(-1.5f, -2.2f, -2.5f),

glm::vec3(-3.8f, -2.0f, -12.3f),

glm::vec3(2.4f, -0.4f, -3.5f),

glm::vec3(-1.7f, 3.0f, -7.5f),

glm::vec3(1.3f, -2.0f, -2.5f),

glm::vec3(1.5f, 2.0f, -2.5f),

glm::vec3(1.5f, 0.2f, -1.5f),

glm::vec3(-1.3f, 1.0f, -1.5f)

};

unsigned int VAO;

glGenVertexArrays(1, &VAO);

glBindVertexArray(VAO);

//存储缓冲区对象id

unsigned int VBO;

//生成缓冲区对象并获取id

glGenBuffers(1, &VBO);

//将缓冲对象绑定到上下文,作为数组缓冲区

glBindBuffer(GL_ARRAY_BUFFER, VBO);

//复制数据到缓冲区

glBufferData(GL_ARRAY_BUFFER, sizeof(vertices), vertices, GL_STATIC_DRAW);

Shader shader("vertex_shader.glsl", "fragment_shader.glsl");

shader.use();

// position attribute

glVertexAttribPointer(0, 3, GL_FLOAT, GL_FALSE, 5 * sizeof(float), (void*)0);

glEnableVertexAttribArray(0);

// texture coord attribute

glVertexAttribPointer(1, 2, GL_FLOAT, GL_FALSE, 5 * sizeof(float), (void*)(3 * sizeof(float)));

glEnableVertexAttribArray(1);

int width, height, nrChannels;

stbi_set_flip_vertically_on_load(true);

unsigned char* data1 = stbi_load("container.jpg", &width, &height, &nrChannels, 0);

unsigned int texture1;

glGenTextures(1, &texture1);

glBindTexture(GL_TEXTURE_2D, texture1);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_WRAP_S, GL_REPEAT);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_WRAP_T, GL_REPEAT);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_MIN_FILTER, GL_LINEAR);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_MAG_FILTER, GL_LINEAR);

glTexImage2D(GL_TEXTURE_2D, 0, GL_RGB, width, height, 0, GL_RGB, GL_UNSIGNED_BYTE, data1);

glGenerateMipmap(GL_TEXTURE_2D);

stbi_image_free(data1);

unsigned char* data2 = stbi_load("awesomeface.png", &width, &height, &nrChannels, 0);

unsigned int texture2;

glGenTextures(2, &texture2);

glBindTexture(GL_TEXTURE_2D, texture2);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_WRAP_S, GL_REPEAT);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_WRAP_T, GL_REPEAT);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_MIN_FILTER, GL_LINEAR);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_MAG_FILTER, GL_LINEAR);

glTexImage2D(GL_TEXTURE_2D, 0, GL_RGB, width, height, 0, GL_RGBA, GL_UNSIGNED_BYTE, data2);

glGenerateMipmap(GL_TEXTURE_2D);

stbi_image_free(data2);

glUniform1i(glGetUniformLocation(shader.ID, "texture1"), 0); // 手动设置

shader.setInt("texture2", 1); // 或者使用着色器类设置

glEnable(GL_DEPTH_TEST);

glfwSetInputMode(window, GLFW_CURSOR, GLFW_CURSOR_DISABLED);

while (!glfwWindowShouldClose(window))

{

float currentFrame = static_cast<float>(glfwGetTime());

deltaTime = currentFrame - lastFrame;

lastFrame = currentFrame;

// 输入

processInput(window);

// 渲染

// 清除颜色缓冲

glClearColor(0.2f, 0.3f, 0.3f, 1.0f);

glClear(GL_COLOR_BUFFER_BIT | GL_DEPTH_BUFFER_BIT);

// 记得激活着色器

shader.use();

// 更新uniform颜色

float timeValue = glfwGetTime();

float greenValue = sin(timeValue) / 2.0f + 0.5f;

shader.setVec4("ourColor", 0.0f, greenValue, 0.0f, 1.0f);

// 绘制三角形

glActiveTexture(GL_TEXTURE0);

glBindTexture(GL_TEXTURE_2D, texture1);

glActiveTexture(GL_TEXTURE1);

glBindTexture(GL_TEXTURE_2D, texture2);

glBindVertexArray(VAO);

glm::mat4 projection;

projection = glm::perspective(glm::radians(camera.Zoom), screenWidth / screenHeight, 0.1f, 100.0f);

unsigned transformLoc = glGetUniformLocation(shader.ID, "projection");

glUniformMatrix4fv(transformLoc, 1, GL_FALSE, glm::value_ptr(projection));

glm::mat4 view;

view = camera.GetViewMatrix();

transformLoc = glGetUniformLocation(shader.ID, "view");

glUniformMatrix4fv(transformLoc, 1, GL_FALSE, glm::value_ptr(view));

for (unsigned int i = 0; i < 10; i++)

{

glm::mat4 model;

model = glm::translate(model, cubePositions[i]);

float angle = 20.0f * i;

model = glm::rotate(model, glm::radians(angle), glm::vec3(1.0f, 0.3f, 0.5f));

transformLoc = glGetUniformLocation(shader.ID, "model");

glUniformMatrix4fv(transformLoc, 1, GL_FALSE, glm::value_ptr(model));

glDrawArrays(GL_TRIANGLES, 0, 36);

}

// 交换缓冲并查询IO事件

glfwSwapBuffers(window);

glfwPollEvents();

}

glDeleteVertexArrays(1, &VAO);

glDeleteBuffers(1, &VBO);

//释放资源

glfwTerminate();

return 0;

}

裁剪¶

- 设置远近平面

void glDepthRange(GLclampd near,GLclampd far); - 用户裁剪:再添加一些任意方向的平面,利用这些平面进行进一步裁剪

- 根据片段到每个裁剪平面的距离来决定是否丢弃该片段。通常,如果该距离小于零,片段会被丢弃

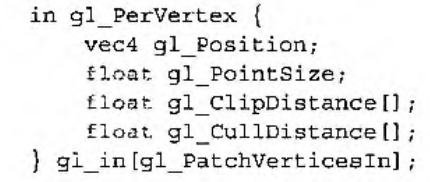

#version 450 core out vec4 fragColor; // 片段颜色 out float gl_ClipDistance[1]; // 裁剪距离 uniform vec4 clipPlane; // 自定义裁剪平面 void main() { // 计算片段到裁剪平面的距离 float distance = dot(gl_FragCoord.xyz, clipPlane.xyz) + clipPlane.w; // 将计算的裁剪距离传递给 gl_ClipDistance gl_ClipDistance[0] = distance; // 输出颜色 fragColor = vec4(1.0, 0.0, 0.0, 1.0); // 红色 }

- 根据片段到每个裁剪平面的距离来决定是否丢弃该片段。通常,如果该距离小于零,片段会被丢弃

- 如果

distance < 0,片段就会被丢弃。gl_ClipDistance:用于片段级裁剪。它控制的是每个片段(像素)是否被裁剪。gl_CullDistance:用于图元级裁剪。它控制的是整个图元(如三角形、线段等)是否被裁剪。

- 多个裁剪平面

#version 450 core out vec4 fragColor; // 输出颜色 out float gl_ClipDistance[3]; // 三个裁剪平面 uniform vec4 clipPlanes[3]; // 裁剪平面,三个平面 void main() { // 计算片段到每个裁剪平面的距离 for (int i = 0; i < 3; ++i) { gl_ClipDistance[i] = dot(gl_FragCoord.xyz, clipPlanes[i].xyz) + clipPlanes[i].w; } // 输出颜色(此处仅为示例,实际颜色处理可能更复杂) fragColor = vec4(1.0, 0.0, 0.0, 1.0); // 红色 }

transform feedback¶

- 用于在图形渲染管线中捕获变换后的顶点数据,并将这些数据输出到缓冲区中,而不是渲染到帧缓冲中。

- 这样可以避免将数据从 GPU 传输到 CPU,再传输回 GPU,从而提高性能。

着色器¶

- 一些运行在 GPU 上的小程序,着色器的功能比较简单,只是接受输入并产生输出

编译着色器¶

- 创建着色器对象

Gluint glCreateShader(GLenum type)- type 可以有

GL_VERTEX_SHADER GL_FRAGMENT_SHADER等

- type 可以有

- 关联着色器代码

void glShaderSource(Gluint shader,GLsizer count,const GLchar** string,const GLint* length) -

编译着色器

void glCompileShader(GLuint shader)- 查询结果

glGetShaderiv(),GL_TRUE 即编译成功 - 查询日志

glGetShaderInfoLog(GLuint shader,GLsizei bufSize,GLsizei*length,char*infoLog)

- 查询结果

-

创建着色器程序

Gluint glCreateProgram(void) - 将着色器附加到着色器程序

void glAttachShader(GLuint program, GLuint shader)- 移除着色器

void glDetchShader(GLuint program,GLuint shader)

- 移除着色器

- 链接生成可执行程序

void GlLinkProgram(GLuint program)- 结果查询

glGetProgramiv() - 日志

glGetProgramInfoLog()

- 结果查询

- 绑定着色器程序

void glUseProgram(GLuint program) - 得到可执行程序 program 后可以释放着色器对象了

glDeleteShader ()- 标记为可删除,当对应的着色器程序不再使用时会自动进行删除

- 删除着色器程序

void glDeleteProgram(Gluint program)

独立着色器对象¶

- 传统方式一个程序绑定一整套多个着色器,如果要更换其中一个着色器就必须更换整个程序

- 独立着色器对象允许开发者将不同的着色器阶段分开管理组合,不需要创建一个完整的着色器程序。即想替换一个着色器只需要重新连接对应的程序

- 每个着色器阶段可以单独编译并存储为一个对象。不同阶段的着色器对象可以在运行时动态组合,而无需重新链接整个程序。

// 顶点和片段着色器代码 const char* vertexShaderSource = "顶点着色器代码..."; const char* fragmentShaderSource = "片段着色器代码..."; // 创建独立着色器对象 GLuint vertexShaderProgram = glCreateShaderProgramv(GL_VERTEX_SHADER, 1, &vertexShaderSource); GLuint fragmentShaderProgram = glCreateShaderProgramv(GL_FRAGMENT_SHADER, 1, &fragmentShaderSource); // 检查编译是否成功 GLint success; glGetProgramiv(vertexShaderProgram, GL_LINK_STATUS, &success); if (!success) { char infoLog[512]; glGetProgramInfoLog(vertexShaderProgram, 512, NULL, infoLog); std::cerr << "ERROR::SHADER::VERTEX::COMPILATION_FAILED\n" << infoLog << std::endl; } // 创建管线对象并绑定 GLuint pipeline; glGenProgramPipelines(1, &pipeline); glBindProgramPipeline(pipeline); // 绑定着色器对象到管线阶段 glUseProgramStages(pipeline, GL_VERTEX_SHADER_BIT, vertexShaderProgram); glUseProgramStages(pipeline, GL_FRAGMENT_SHADER_BIT, fragmentShaderProgram); // 绘制 glBindProgramPipeline(pipeline); glBindVertexArray(VAO); glDrawArrays(GL_TRIANGLES, 0, 3);

GLSL¶

- 着色器程序通常的结构

#version version_number in type in_variable_name; in type in_variable_name; out type out_variable_name; uniform type uniform_name; void main() { // 处理输入并进行一些图形操作 ... // 输出处理过的结果到输出变量 out_variable_name = weird_stuff_we_processed; } - 能声明的顶点属性是有上限的,它一般由硬件来决定,OpenGL确保至少有16个包含4分量的顶点属性可用

-

查询

glGetIntegerv(GL_MAX_VERTEX_ATTRIBS, &nrAttributes); -

glsl 代码与 c 接近,开始于版本声明,与 opengl 类似,如 3.3 版本对应 330

#version 330 core -

invariant添加在 out 变量前面,保证使用相同输入进行相同计算总是得到相同的结果,用于保证多个着色器阶段输出一致#pragma STDGL invariant(all)全局开启- 会关闭一些优化,解决插值、浮点数计算的微小误差

precise保证变量的计算遵循最高的精度标准,避免因为优化引入的不精确计算- 在指定的变量前添加

precise

- 在指定的变量前添加

| 修饰符 | 作用范围 | 主要功能 | 优势 | 注意事项 |

|---|---|---|---|---|

invariant |

输出变量 | 保证跨着色器阶段的一致性 | 避免几何边界上插值出现不连续 | 性能可能降低,慎用 |

precise |

局部变量、计算过程 | 提升计算过程的精度,避免优化引入误差 | 确保高精度计算(如物理模拟) | 可能影响性能,影响有限场景 |

- 控制着色器编译优化 pragma optimize(on/off) |

||||

- 额外诊断信息 pragma debug(on/off) |

数据类¶

- 除了基本数据类型int、float、double、bool等,有两种容器类型:vector和matrix

-

-

向量可以包含2~4个分量

| 类型 | 含义 |

|---|---|

vecn |

包含n个float分量的默认向量 |

bvecn |

包含n个bool分量的向量 |

ivecn |

包含n个int分量的向量 |

uvecn |

包含n个unsigned int分量的向量 |

dvecn |

包含n个double分量的向量 |

- 大部分时候使用vecn即可

- 通过

.x、.y、.z和.w来获取分量 - GLSL也允许对颜色使用

rgba,或是对纹理坐标使用stpq访问相同的分量。

//灵活的组合运算

vec2 someVec;

vec4 differentVec = someVec.xyxx;

vec3 anotherVec = differentVec.zyw;

vec4 otherVec = someVec.xxxx + anotherVec.yxzy;

//创建变量

vec2 vect = vec2(0.5, 0.7);

vec4 result = vec4(vect, 0.0, 0.0);

vec4 otherResult = vec4(result.xyz, 1.0);

输入输出¶

- 使用

in和out关键字来定义输入输出 - 每个着色器使用这两个关键字设定输入和输出,只要一个输出变量与下一个着色器阶段的输入匹配,它就会传递下去。

- 特殊输入:其中顶点着色器是从缓冲区获取顶点元数据,通过设置

location来获取CPU配置的属性,如layout (location = 0) - 特殊输出:片段着色器的输出为

vec4(RGBA) - 点着色器示例

#version 330 core

layout (location = 0) in vec3 aPos; // 位置变量的属性位置值为0

out vec4 vertexColor; // 为片段着色器指定一个颜色输出

void main()

{

gl_Position = vec4(aPos, 1.0); // 注意我们如何把一个vec3作为vec4的构造器的参数

vertexColor = vec4(0.5, 0.0, 0.0, 1.0); // 把输出变量设置为暗红色

}

- 片段着色器示例

#version 330 core

out vec4 FragColor;

in vec4 vertexColor; // 从顶点着色器传来的输入变量(名称相同、类型相同)

void main()

{

FragColor = vertexColor;

}

函数的参数传递¶

- glsl 没有指针类型,通过参数的访问修饰符来进行设定

- 同与外部的通讯 in、out 是类似的

in:仅作输入,用于从调用者向函数传递数据。out:仅作输出,用于从函数向调用者传递数据。inout:作为输入和输出,用于修改调用者提供的数据。(类似引用传递)void example(inout float value) { value *= 2.0; // 修改 value } void main() { float value = 21.0; example(value); // value 被修改为 42.0 }

uniform¶

- 实现从CPU传递数据到GPU上的着色器(如从应用程序直接发送一个颜色给片段着色器)

- uniform是全局作用域的,因此在所有着色器程序中都不能重名

-

uniform vec4 ourColor; -

要注意的是激活新的着色器程序后,必须要重新传递所有的uniform变量

//在片段着色器中使用uniform变量

#version 330 core

out vec4 FragColor;

uniform vec4 ourColor; // 在OpenGL程序代码中设定这个变量

void main()

{

FragColor = ourColor;

}

//在程序循环中设置颜色

float timeValue = glfwGetTime();

float greenValue = (sin(timeValue) / 2.0f) + 0.5f;

int vertexColorLocation = glGetUniformLocation(shaderProgram, "ourColor");//获取uniform变量的位置值

glUseProgram(shaderProgram);

//参数位置+参数(4个)

glUniform4f(vertexColorLocation, 0.0f, greenValue, 0.0f, 1.0f);

glsl中通常的表示类型的后缀

| 后缀 | 含义 |

|---|---|

f |

函数需要一个float作为它的值 |

i |

函数需要一个int作为它的值 |

ui |

函数需要一个unsigned int作为它的值 |

3f |

函数需要3个float作为它的值 |

fv |

函数需要一个float向量/数组作为它的值 |

| ##### 接口块 |

- 通过接口快可以组合要从顶点着色器发送到片段着色器的数据

#version 330 core

layout (location = 0) in vec3 aPos;

layout (location = 1) in vec2 aTexCoords;

uniform mat4 model;

uniform mat4 view;

uniform mat4 projection;

out VS_OUT

{

vec2 TexCoords;

} vs_out;

void main()

{

gl_Position = projection * view * model * vec4(aPos, 1.0);

vs_out.TexCoords = aTexCoords;

}

//片段着色器中

in VS_OUT

{

vec2 TexCoords;

} fs_in;

- 这就生命力一个

vs_out接口块,打包了要发送的所有输出变量 - 输入和输出的块名(VS_OUT)要一样,但是实例名可以不一样

数据块接口¶

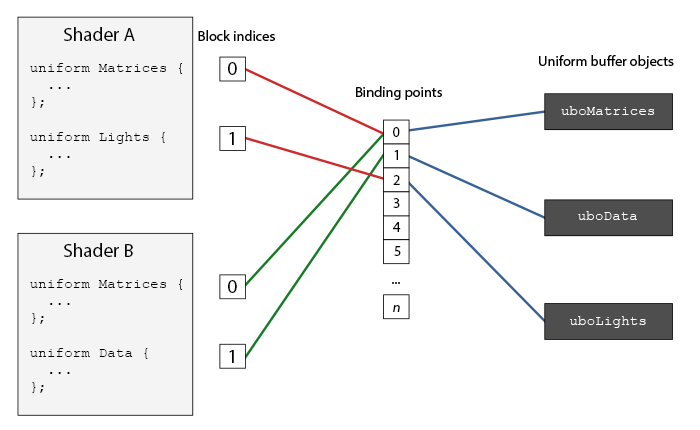

- 使用 Uniform 缓冲对象可以定义协议系列在多个着色器程序中相同的全局 Uniform 变量,这样就只需要设置相关的 uniform 一次,只需要手动设置每个着色器中不同的 uniform

-

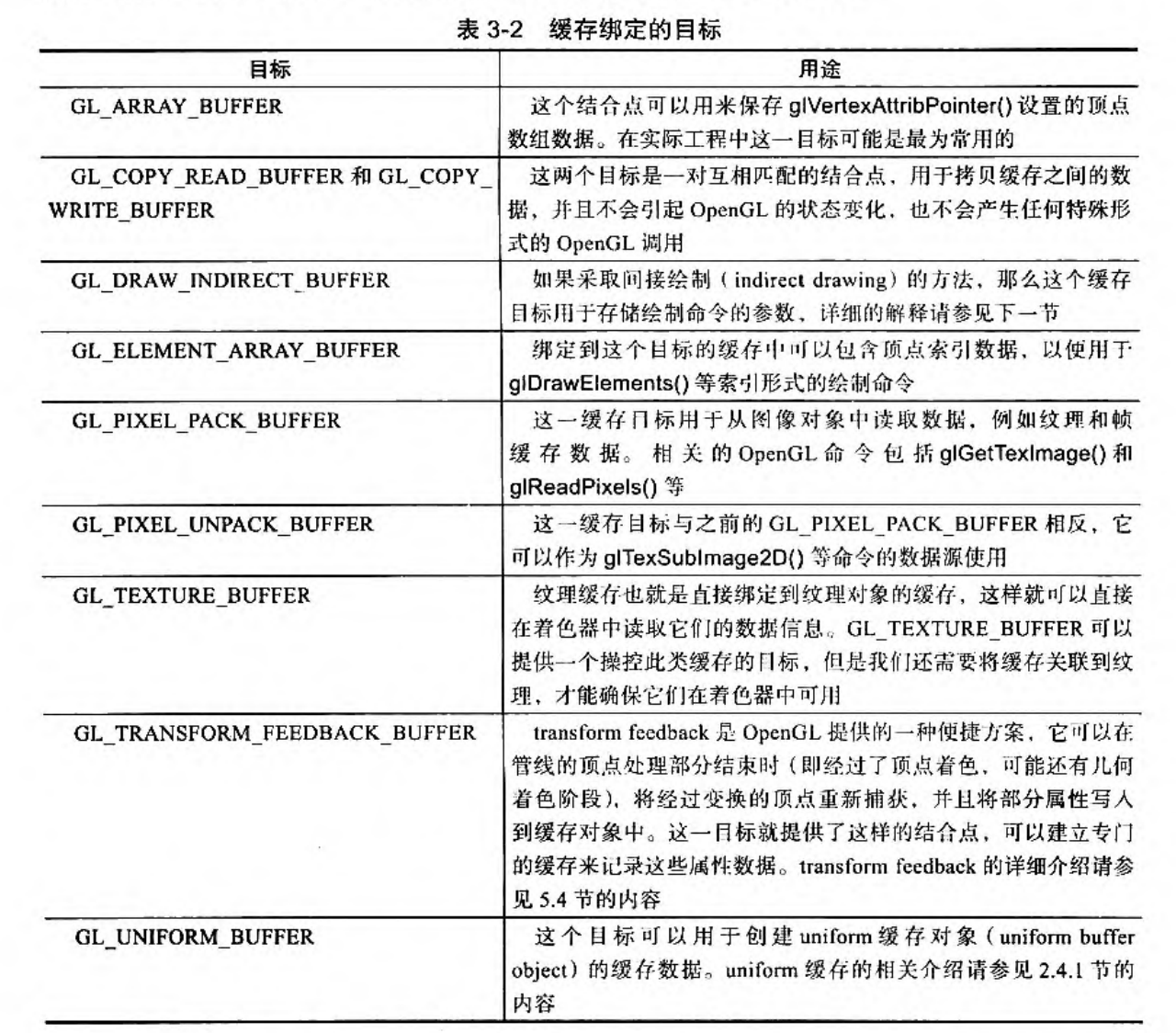

通过 glGenBuffers 创建缓冲,并绑定到 GL_UNIFORM_BUFFER 缓冲目标,并将所有相关的 uniform 数据存入缓冲。

-

uniform 块

- Uniform 块中的变量可以直接访问,不需要加块名作为前缀。

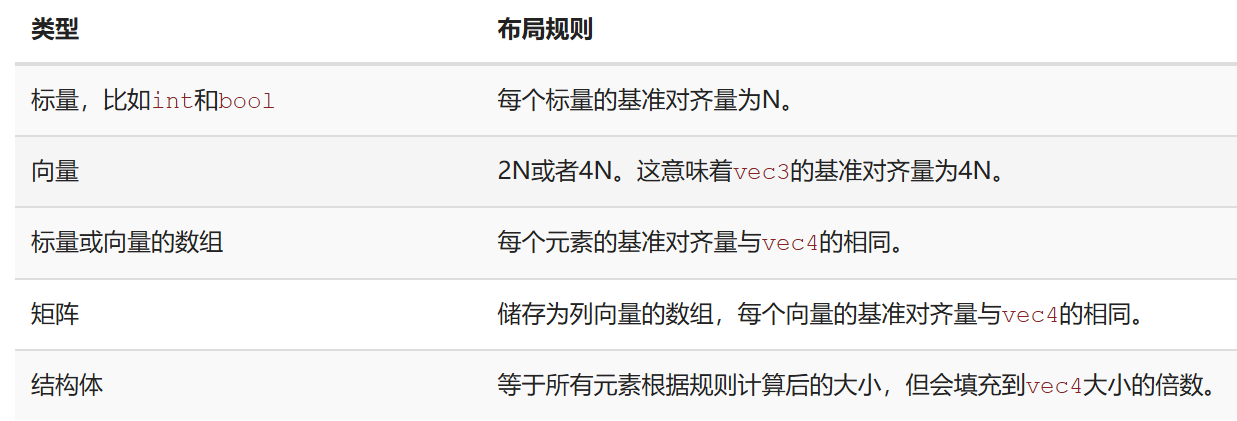

- layout (std 140) 表示当前定义的 Uniform 块对它的内容使用一个特定的内存布局

layout (std140) uniform ExampleBlock

{

float value;

vec3 vector;

mat4 matrix;

float values[3];

bool boolean;

int integer;

};

-

uniform 块的内容是存储在缓冲对象上的,我们还需要告诉 opengl 缓冲对象内存的那一部分对应哪一个 uniform 块成员变量

-

我们需要知道的是每个变量的大小(字节)和(从块起始位置的)偏移量,来让我们能够按顺序将它们放进缓冲中。

-

通常使用std 布局:std 140 布局声明了每个变量的偏移量都是由一系列规则所决定的。同时允许手动计算变量的偏移量

-

在默认的共享布局(Shared Layout)中,变量的实际偏移量需要通过

glGetUniformLocation等API 动态查询,不仅复杂,而且增加了运行时开销。std140布局通过明确的规则直接决定偏移量,使得我们可以手动计算偏移,省去了查询的麻烦。 -

基准对齐量:变量在 Uniform 块中所需的最小对齐空间,包括潜在的填充字节

-

对齐偏移量:变量在块中的实际偏移量,必须是其基准对齐量的整数倍。

-

- 通常 N=4 B

layout (std140) uniform ExampleBlock

{

// 基准对齐量 // 对齐偏移量

float value; // 4 // 0

vec3 vector; // 16 // 16 (必须是16的倍数,所以 4->16)

mat4 matrix; // 16 // 32 (列 0)

// 16 // 48 (列 1)

// 16 // 64 (列 2)

// 16 // 80 (列 3)

float values[3]; // 16 // 96 (values[0])

// 16 // 112 (values[1])

// 16 // 128 (values[2])

bool boolean; // 4 // 144

int integer; // 4 // 148

};

- uniform缓冲对象 ubo:GPU 显存中的缓冲区,用于存储 uniform 块的数据

- Uniform 块是 GLSL 中的一个结构,用于统一管理多个

uniform变量 - 绑定点起到了桥梁作用,沟通 ubo 和 uniform 块

- 通过将多个 Uniform 块绑定到相同的缓冲上,就可以实现数据的共享(如果定义了相同的 Uniform 块)

//创建缓冲UBO

unsigned int uboExampleBlock;

glGenBuffers(1, &uboExampleBlock);

glBindBuffer(GL_UNIFORM_BUFFER, uboExampleBlock);

glBufferData(GL_UNIFORM_BUFFER, 152, NULL, GL_STATIC_DRAW); // 分配152字节的内存

glBindBuffer(GL_UNIFORM_BUFFER, 0);

//Uniform块绑定到一个特定的绑定点中

//获取uniform块的索引

unsigned int lights_index = glGetUniformBlockIndex(shaderA.ID, "Lights");

//将uniform块绑定到2绑定点

glUniformBlockBinding(shaderA.ID, lights_index, 2);

//将ubo绑定到绑定点

glBindBufferBase(GL_UNIFORM_BUFFER, 2, uboExampleBlock);

-

也可以这样讲 uniform 块绑定到绑定点

layout(std140, binding = 2) uniform Lights { ... }; -

修改 uniform 缓冲中的内容

glBindBuffer(GL_UNIFORM_BUFFER, uboExampleBlock);

int b = true; // GLSL中的bool是4字节

glBufferSubData(GL_UNIFORM_BUFFER, 144, 4, &b);

glBindBuffer(GL_UNIFORM_BUFFER, 0);

buffer 块¶

- 着色器的存储缓存对象,比 uniform 块更强大,着色器可以写入块,修改内容并呈现给其他着色器调用、应用程序本身。

- 可以在渲染之前决定大小而不是在编译和链接的时候

buffer BufferObject { int mode; vec points[];//最后一个元素可以是未定大小的数组 }

- 可以在渲染之前决定大小而不是在编译和链接的时候

- 上面的数组就可以在渲染之前再设置大小,着色器中可以使用

length()来获取数组的大小

附:着色器管理类¶

- 从硬盘读取着色器,编译、链接、检查

#ifndef SHADER_H

#define SHADER_H

#include <glad/glad.h>

#include <string>

#include <fstream>

#include <sstream>

#include <iostream>

class Shader

{

public:

unsigned int ID;

// constructor generates the shader on the fly

// ------------------------------------------------------------------------

Shader(const char* vertexPath, const char* fragmentPath)

{

// 1. retrieve the vertex/fragment source code from filePath

std::string vertexCode;

std::string fragmentCode;

std::ifstream vShaderFile;

std::ifstream fShaderFile;

// ensure ifstream objects can throw exceptions:

vShaderFile.exceptions (std::ifstream::failbit | std::ifstream::badbit);

fShaderFile.exceptions (std::ifstream::failbit | std::ifstream::badbit);

try

{

// open files

vShaderFile.open(vertexPath);

fShaderFile.open(fragmentPath);

std::stringstream vShaderStream, fShaderStream;

// read file's buffer contents into streams

vShaderStream << vShaderFile.rdbuf();

fShaderStream << fShaderFile.rdbuf();

// close file handlers

vShaderFile.close();

fShaderFile.close();

// convert stream into string

vertexCode = vShaderStream.str();

fragmentCode = fShaderStream.str();

}

catch (std::ifstream::failure& e)

{

std::cout << "ERROR::SHADER::FILE_NOT_SUCCESSFULLY_READ: " << e.what() << std::endl;

}

const char* vShaderCode = vertexCode.c_str();

const char * fShaderCode = fragmentCode.c_str();

// 2. compile shaders

unsigned int vertex, fragment;

// vertex shader

vertex = glCreateShader(GL_VERTEX_SHADER);

glShaderSource(vertex, 1, &vShaderCode, NULL);

glCompileShader(vertex);

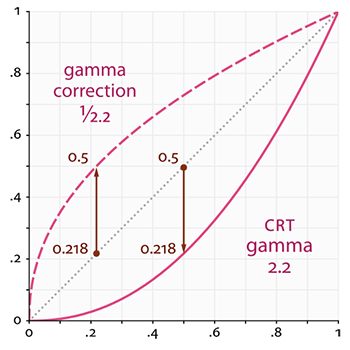

checkCompileErrors(vertex, "VERTEX");